文章摘要

【关 键 词】 机器学习、GPU短缺、资源不均、计算集群、教育合作

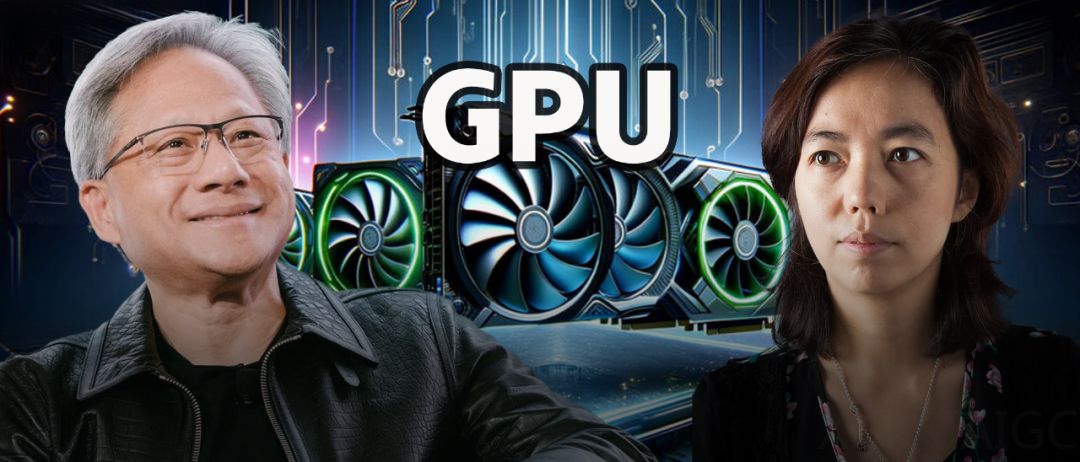

在机器学习(ML)领域,高性能图形处理单元(GPU)是进行复杂计算和模型训练的关键资源。然而,近期一位美国顶尖五所高校之一的机器学习博士在Reddit上发帖,揭示了其实验室中H100 GPU的数量为零,这一现象引发了全球机器学习社区的广泛关注和讨论。

该博士表示,在其攻读博士期间,计算资源的短缺是一个主要瓶颈。如果有更多的高性能GPU,可以显著缩短计算时间,加快研究进度。而另一位亚洲网友分享了自己的经历,从2019年的一块2080 Ti显卡开始,到2024年可以使用配有8块H100 GPU的服务器,但大多数资源都是共享的。

在讨论中,一些网友指出,并非所有实验室都需要大量高端GPU。机器学习的基础在于线性代数、统计学和编程技能,硬件优化是之后考虑的问题。而且,0 GPU的情况并不罕见,因为学习开车并不需要法拉利。

然而,GPU资源的短缺在国内外高校的实验室中普遍存在。一些课程甚至要求学生自备高性能计算设备,以完成课程要求的LLM训练任务。

尽管如此,一些高校如普林斯顿语言与智能研究所(PLI)和哈佛Kempner研究所拥有较大的计算集群,分别配备了300块和400块H100 GPU。普林斯顿的研究者证实了这一信息,并提到在普林斯顿,可以使用的集群有三种,包括小组集群、部门集群等,资源分配根据具体情况而定。

总的来说,GPU资源在机器学习领域的分布存在显著的不均衡性。一些顶尖高校拥有丰富的GPU资源,而许多其他学校和研究机构则面临GPU短缺的问题。这不仅影响了研究进度,也对学生的学习和研究造成了一定的困扰。解决这一问题需要高校、企业和研究机构之间的合作,以及更合理的资源分配和共享机制。同时,培养机器学习研究者的基本技能和优化硬件使用也是提高研究效率的重要途径。

原文和模型

【原文链接】 阅读原文 [ 5830字 | 24分钟 ]

【原文作者】 新智元

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★