文章摘要

【关 键 词】 AI视频、唇形同步、动态生成、多人生成、影视革新

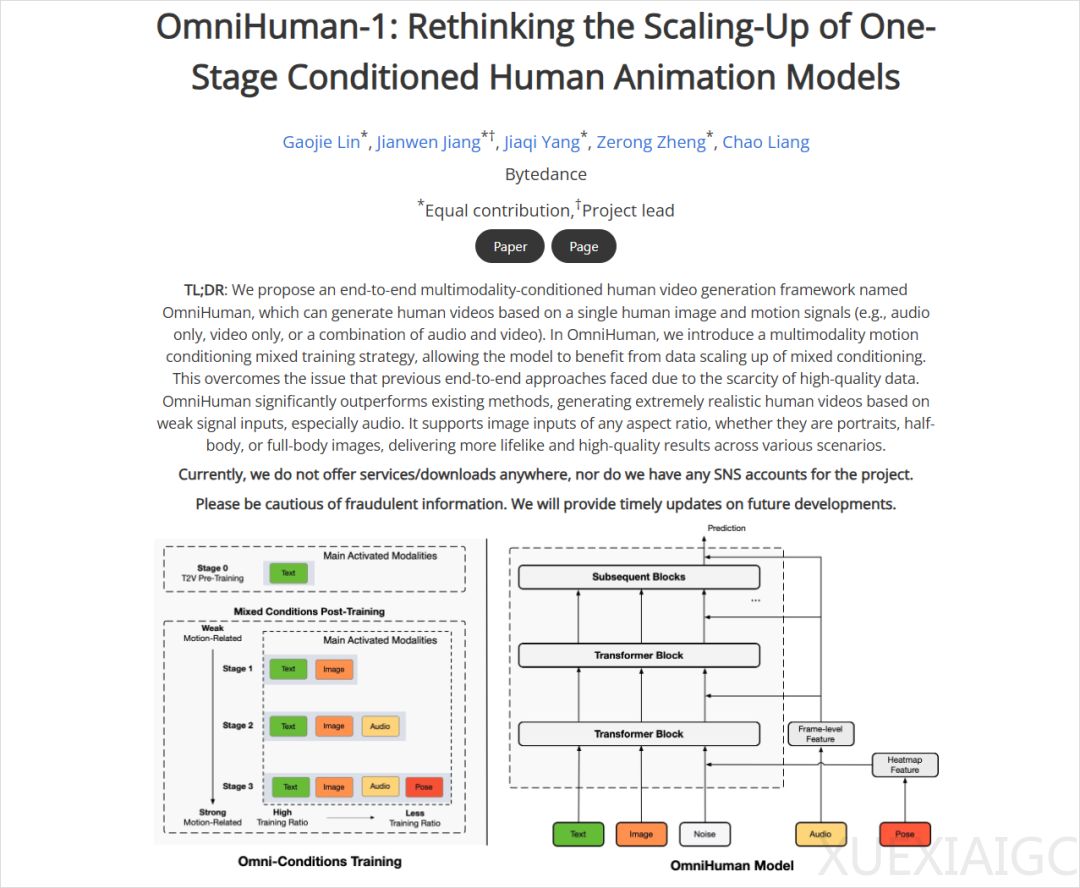

字节跳动推出的OmniHuman-1模型近期开启内测,其通过单张人物图像与音频输入生成动态视频的能力引发广泛关注。该技术不仅实现高精度唇形同步,还突破性地支持全身动作与动态背景生成,标志着AI视频生成进入新阶段。与此前仅能处理面部动画的“照片说话”技术相比,OmniHuman-1通过端到端处理,使人物肢体动作、背景动态与语音表达实现一体化输出,大幅提升视频的真实感与表现力。

技术应用流程显示,用户需准备人物图像与音频素材,上传至“即梦”平台后即可生成15秒视频。测试案例中,哪吒、奥特曼等角色在动态场景中的自然表演,以及多人场景的初步支持,验证了模型在肢体协调、场景连贯性上的显著进步。值得注意的是,当前版本对角色审核较为严格,动物或非标准人像可能无法识别,产品方回应称此为模型特性而非技术漏洞。

从技术效果看,OmniHuman-1展现出三大核心突破:首先,动态背景与人物动作的同步生成解决了传统技术中“静态背景”的违和感;其次,语音驱动口型的精准度接近专业影视级效果;最后,多人交互场景的初步探索为AI视频创作开辟新可能。测试者通过AI生成的奥特曼战斗场景与虚拟歌手表演案例,证实了模型在复杂动作编排上的潜力。

该技术对影视、广告等内容生产领域可能产生颠覆性影响。传统需数周完成的动画制作、配音匹配流程,现可压缩至数十秒完成,且支持批量生成。行业观察指出,这种效率跃升或将重构动画制作、直播互动等产业模式,但也引发对AI冲击传统影视工业的讨论。

尽管存在角色识别限制与细节瑕疵,OmniHuman-1仍被视作AI视频2.0时代的里程碑。其核心价值在于将视频从单纯的视觉载体转变为融合表演、叙事与交互的复合媒介,为AI深度参与创意表达提供了技术基础。随着多模态技术的持续演进,动态生成技术的应用边界或将进一步拓展至教育、虚拟偶像等更广泛场景。

原文和模型

【原文链接】 阅读原文 [ 1252字 | 6分钟 ]

【原文作者】 数字生命卡兹克

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆