文章摘要

【关 键 词】 逻辑推理、视觉推理、多模态、模型测试、公考行测

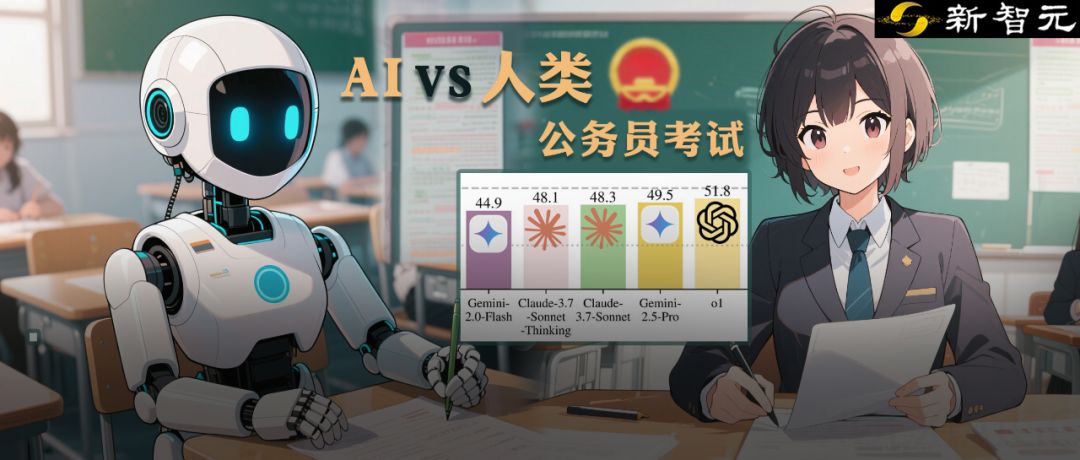

卡内基梅隆大学(CMU)的研究团队针对公务员考试中的逻辑推理题,设计了一套名为VisualPuzzles的视觉推理基准测试,旨在评估多模态大模型的推理能力。该测试包含1168道图文逻辑题,主要来源于中国国家公务员考试行测中的逻辑推理题,涵盖了算法推理、类比推理、演绎推理、归纳推理和空间推理五大类型。测试结果显示,即便是最先进的AI模型,如o1、Gemini-2.5 Pro和Claude-3.7-Sonnet,其正确率也仅为57.5%,远低于人类顶尖选手的接近满分表现。这表明,当前的AI模型在纯逻辑推理方面与人类仍存在显著差距。

研究进一步揭示了几个关键发现。首先,知识并不等同于推理能力。尽管在知识密集型基准测试(如MMMU)中,模型的表现与知识掌握程度高度相关,但在VisualPuzzles中,这种相关性显著降低。这意味着,模型无法仅依靠记忆中的知识来解决需要复杂推理的问题。其次,模型规模的扩大并不一定带来推理能力的提升。在VisualPuzzles中,更大的模型参数规模并未显著提高推理准确率,这与在MMMU中的表现形成鲜明对比。此外,更多的token输出也不意味着更好的推理。尽管一些模型在输出中增加了详细的推理过程,但其正确率并未因此提高,表明这些模型可能只是在“装饰”推理过程,而非真正进行深度逻辑推理。

研究还发现,模型在VisualPuzzles中的表现与其在MMMU中的表现存在显著差异。在MMMU中,模型倾向于通过排除法快速选择答案,而在VisualPuzzles中,模型更倾向于独立解决问题后再与选项进行比较。这种策略的差异进一步凸显了模型在纯逻辑推理任务中的不足。此外,模型在空间推理和视觉感知方面的表现也不稳定,尤其是在涉及物体位置、形状和角度的题目中,错误率较高。

尽管模型在不同推理类别之间存在一定的泛化能力,但这种泛化可能只是基于某些通用的“表面模式”,而非真正的多样化推理能力。这表明,模型在推理任务中的表现仍然依赖于其训练数据中的特定模式,而非真正的逻辑理解。

VisualPuzzles的出现为多模态大模型的发展指明了方向。未来的研究需要关注如何在训练过程中强化推理结构,而非单纯依赖知识记忆。此外,设计兼具复杂逻辑与通用认知的新型网络或推理模块,以及扩展到多图、多步骤或动态场景的推理,也是未来研究的重要方向。总之,在不断扩大模型规模和补充知识的同时,提升模型的真正理解与推理能力,将是AI发展的关键。

原文和模型

【原文链接】 阅读原文 [ 4369字 | 18分钟 ]

【原文作者】 新智元

【摘要模型】 deepseek/deepseek-v3/community

【摘要评分】 ★★★★★