文章摘要

【关 键 词】 神经网络、MLP、KAN、激活函数、可解释性

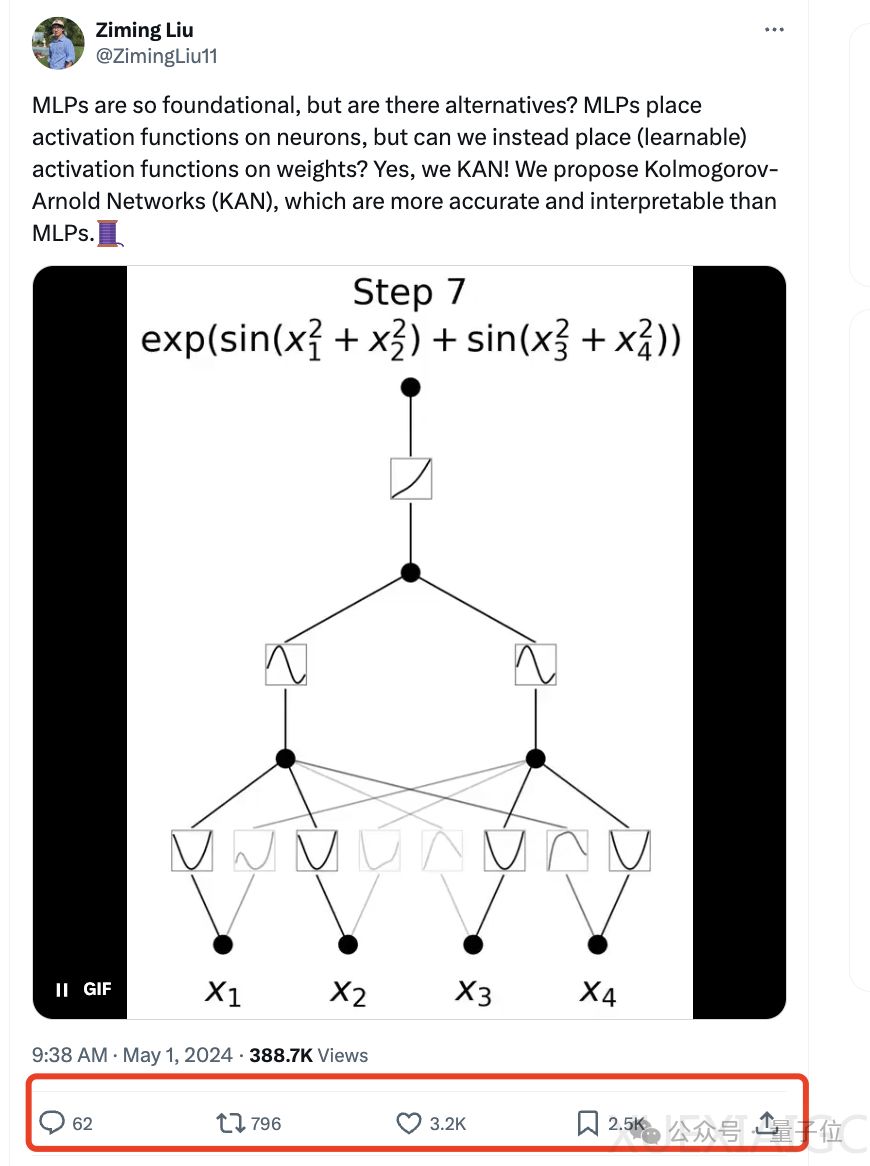

一种名为KAN的全新神经网络架构被提出,它与传统的MLP(多层感知机)架构有显著不同,并且在使用更少的参数的情况下,在数学和物理问题上取得了更高的精度。例如,使用200个参数的KANs能够复现DeepMind使用30万参数的MLPs在数学定理研究中的发现,并且还发现了新的公式。KAN在函数拟合、偏微分方程求解以及处理凝聚态物理任务方面的表现均优于MLP。此外,KAN在解决大模型问题时能够避免灾难性遗忘问题,并且更容易融入人类的习惯偏差或领域知识。

KAN的研究由来自MIT、加州理工学院、东北大学等团队进行,其成果迅速在科技圈内引起关注。KAN的出现也引发了关于是否能替代Transformer中MLP层的讨论,有研究者已经开始尝试这一可能性。一些观点认为KAN可能代表了机器学习的下一步,即让机器学习每个特定神经元的最佳激活,而不是由人类决定使用什么激活函数。KAN的相关代码已在GitHub上开源,并在短时间内获得了显著的关注。

KAN的核心区别在于,它将可学习的激活函数放在权重上,而不是像MLP那样放在神经元上。这种设计灵感来源于Kolmogorov-Arnold表示定理(KART),该定理表明每个多元连续函数都可以表示为单变量连续函数的两层嵌套叠加。基于这一定理,研究人员将Kolmogorov-Arnold表示参数化,创建了科尔莫格罗夫-阿诺德网络(KANs),以纪念两位伟大的数学家Andrey Kolmogorov和Vladimir Arnold。与MLPs不同,KANs在权重上具有可学习的激活函数,这些激活函数被参数化为样条曲线。KAN提供了MLP无法提供的可解释性和交互性,并且可以直观地可视化。

然而,KAN也存在缺点,即训练速度较慢。这主要是因为可学习的激活函数评估成本比固定激活函数成本更高,以及研究人员没有尝试优化效率。对于是否能适配Transformer和对GPU的友好性,研究人员表示目前还在努力中。

在具体实现效果方面,KAN在神经缩放规律上的缩放速度比MLP快得多,这不仅得益于Kolmogorov-Arnold表示定理的数学基础,还可以通过经验来实现。在函数拟合方面,KAN比MLP更准确。

原文和模型

【原文链接】 阅读原文 [ 2635字 | 11分钟 ]

【原文作者】 量子位

【摘要模型】 gpt-4

【摘要评分】 ★★★★★