文章摘要

【关 键 词】 水印技术、AI识别、文本检测、内容安全、开源模型

本文探讨了水印技术在识别由大型语言模型(LLM)生成的文本以及减少AI危害方面的局限性。作者David Gilbertson通过一系列思想实验,质疑了水印技术的有效性,并提出了三个条件,说明为什么水印无法实现区分AI生成文本和人类生成文本的目标。

首先,作者指出,要使水印技术有效,必须所有有能力的LLM都实现水印功能。然而,由于不带水印的开源模型已经存在,如Llama 3.1 405B,这使得水印技术的普及变得不可能。其次,如果所有LLM都带有水印,那么LLM提供商将无法允许用户将温度设置为0,这将影响LLM的随机性和统计水印的有效性。此外,LLM提供商也将无法提供用户访问每个词元的备用选项,这将限制LLM的功能。第三,作者认为,不存在开源模型是实现水印技术的另一个条件,因为开源模型可以轻易移除水印机制。

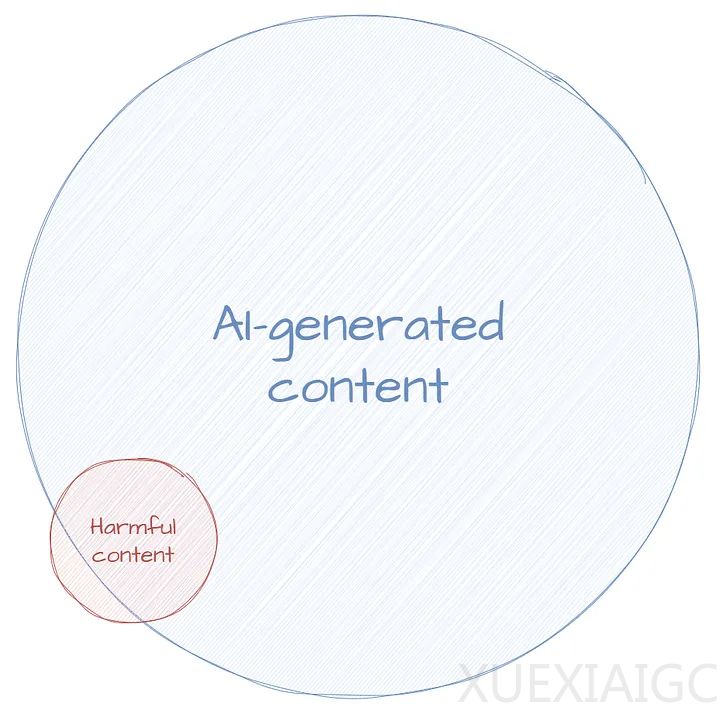

作者进一步质疑了检测AI生成文本的目标是否有意义,指出AI文本与人类文本之间的区别不是二元对立的,且并非所有AI生成的内容都是有害的。他建议,真正的目标应该是检测和减少有害内容,而不是专注于检测AI生成的内容。

最后,作者提出了一系列问题,挑战水印支持者和政策制定者,质疑他们对水印技术的期望和假设。他强调,水印技术可能在某些方面有用,如帮助LLM开发者检测其LLM生成的内容,但并不包括减少社会危害。作者呼吁人们关注更实际的解决方案,如检测真实内容,而不是依赖水印技术。

原文和模型

【原文链接】 阅读原文 [ 8515字 | 35分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...