为什么说DeepSeek的R1-Zero比R1更值得关注?

文章摘要

【关 键 词】 AI模型、强化学习、推理能力、经济转变、数据预训练

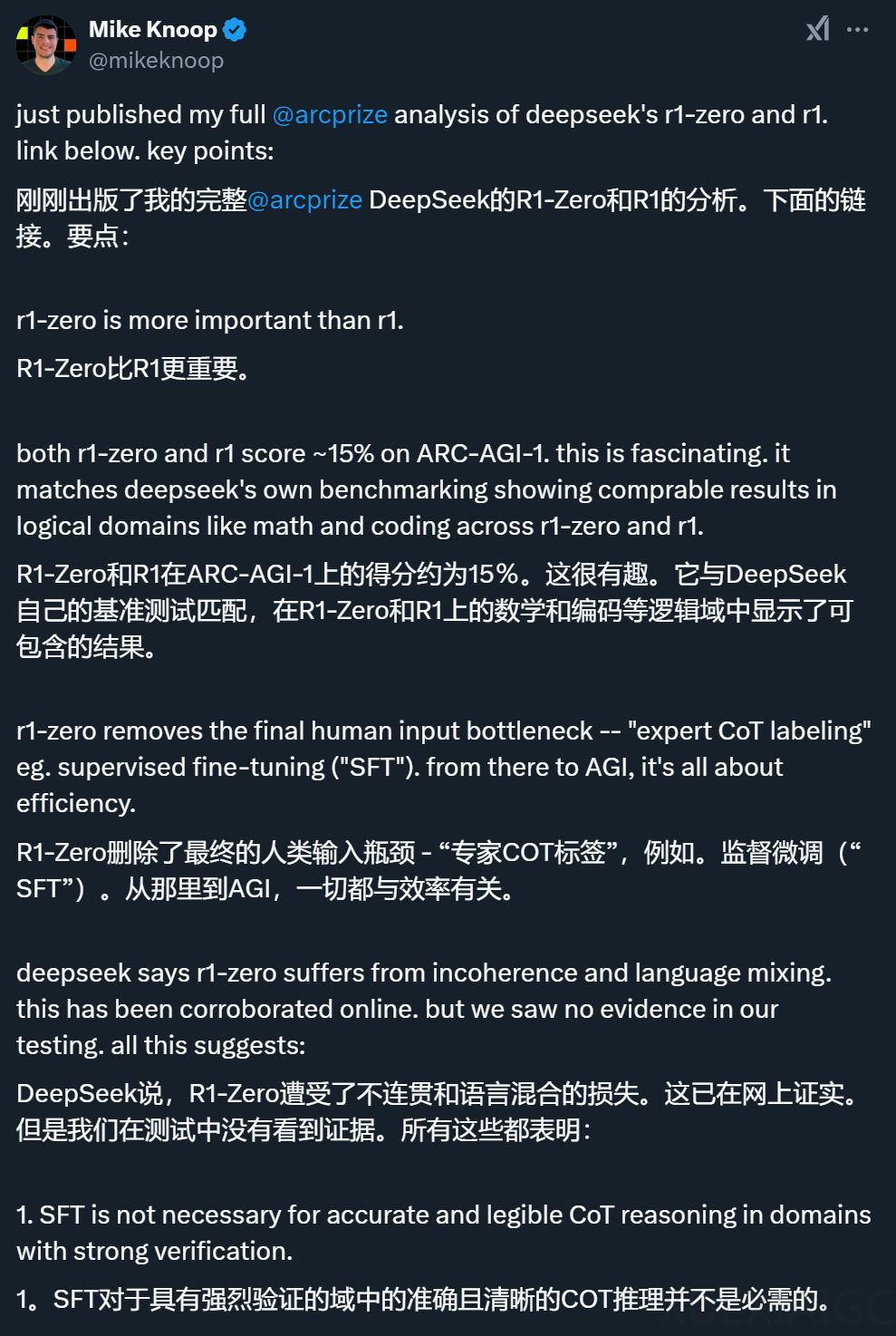

DeepSeek发布的R1-Zero和R1两个模型在ARC-AGI-1上的得分与OpenAI的o1系统低计算量版本相当,显示出纯LLM scaling的局限性。R1-Zero特别值得关注,因为它完全依赖于强化学习(RL),不使用人类专家标注的监督微调(SFT),这表明在某些任务中,人类标注并非必要,且未来可能通过纯RL方法实现更广泛的推理能力。R1-Zero的成功展示了一个潜在的scaling机制原型,该机制完全没有人类瓶颈,甚至在训练数据获取本身也是如此。

从经济角度来看,AI领域正在发生两个重大转变:一是现在可以花更多钱来获得更高的准确性和可靠性;二是训练成本正在转向推理成本。这两者都将推动对推理的大量需求,而且都不会抑制对更多计算能力的需求。AI推理系统带来的价值远不止提高基准测试的分数那么简单,阻碍更多AI自动化使用的首要问题是可靠性。现在有证据表明,模型在ARC-AGI方面的进展将提高可靠性。

另一个正在发生的重大转变是进入LLM系统预训练的数据来源。现在,通过推理系统和验证器,我们可以创造全新的、有价值的训练数据。这种数据的产生有两种方式:要么是开发者提前付费生成,要么是在用户实际使用系统时由用户付费生成。这是一个引人深思的经济模式转变,暗示着拥有最多付费用户的AI系统开发商可能会拥有一个实力快速积累的关键时刻。

随着推理需求增加变得明显,市场调整将继续发生。AI系统效率只会推动更多使用,这不仅是由于杰文斯悖论,还因为效率提高时新的训练机制被解锁。随着R1的开源和可复现,更多人和团队将把CoT和搜索推向极限,这将更快地告诉我们前沿实际在哪里,并将推动一波创新浪潮,增加快速实现AGI的机会。

原文和模型

【原文链接】 阅读原文 [ 2915字 | 12分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆