文章摘要

【关 键 词】 大型语言模型、数据处理、表格数据查询、LlamaIndex、LocalAI

在数据处理与分析领域,大型语言模型(LLM)正在引领潮流,展现出超越传统文本应用的突破性功能。其中,利用LLMs解读和推理表格数据是一个值得关注且潜力巨大的应用领域。在这个领域中,两项创新技术发挥着关键作用:LlamaIndex 和 LocalAI。

LlamaIndex在研究过程中扮演着核心角色,它遵循了前沿论文“Rethinking Tabular Data Understanding with Large Language Models” 及“Chain-of-Table: Evolving Tables in the Reasoning Chain for Table Understanding”的指导原则,将理论转化为实践。与此相辅相成的是 LocalAI,它提供了一个无缝衔接的本地环境,使得用户可以便捷地在本地启动 LLM 并与之互动。

在表格数据领域,LLM面临的挑战和机遇主要来自于表格数据的结构化且复杂的特性。在处理表格数据时,需要考虑到结构扰动的鲁棒性、文本推理与符号推理的比较分析,以及通过推理路径提升性能等因素。此外,还需要考虑到链式表格(Chain-of-Table)的概念,这一概念彻底改变了LLM与表格数据交互的方式。

LlamaIndex是构建大型语言模型应用程序必不可少的多功能“数据框架”。它简化了从各种来源和格式获取数据的过程,包括 API、PDF、文档和 SQL。Llama Packs则是LlamaIndex的补充,它作为社区驱动的中心,提供了一系列预打包模块,以加速LLM应用程序的开发。

LocalAI的目标是在本地运行开源基础大模型服务,然后提供与OpenAI完全兼容的API,为那些寻求本地推理能力但是又想保持使用OpenAI灵活性的用户提供了一种独特的解决方案。LocalAI功能包括运行LLMs、生成图像、制作音频,其应用范围十分广泛。

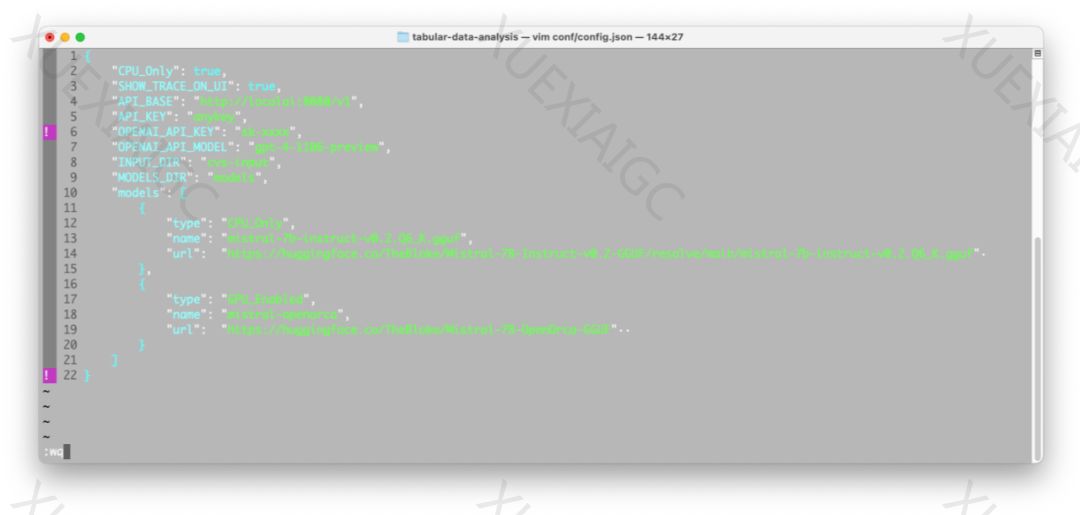

在实际演示中,我们展示了如何使用LocalAI提供的Docker镜像来启动本地LLM,并展示了如何将其与OpenAI兼容的API服务进行对接。我们提供了实战演练,全程指导用户在Docker容器中搭建整套系统,确保其既适用于仅配备CPU的机器,也能适应拥有GPU设备的环境。

在查询引擎的运作机制中,我们使用了两种查询引擎:“MixSelfConsistency”和“ChainOfTable”。这两种查询引擎各有优点和缺点,但都能有效地处理表格数据的查询。

在与LLMs的交互中,我们使用了与OpenAI兼容的API服务作为应用程序和LLMs之间的中介,以提高模块化和增强灵活性。此外,我们还注意到在构建Docker镜像过程中,需要管理Docker镜像的大小,以提高效率和性能。

总的来说,通过使用LLMs,我们可以更有效地处理和分析表格数据,这不仅是一项专业任务,更蕴含着巨大的潜力,它有望革新我们与结构化数据集交互的方式。

原文和模型

【原文链接】 阅读原文 [ 5144字 | 21分钟 ]

【原文作者】 AI前线

【摘要模型】 gpt-4-32k

【摘要评分】 ★★★★★