文章摘要

【关 键 词】 AI爬虫、版权争议、网站负载、用户体验、法律地位

Mozilla工程师Dennis Schubert近期公开指责大型模型公司爬取内容导致网站负载过高,运行变慢。他发现,其负责的diaspora项目在过去60天内收到1130万条请求,其中70%的负载来自大模型训练操作,这些爬虫每6小时爬取一次,对服务器性能和用户体验造成严重影响。Schubert计划将这些爬虫重定向到随机生成的文本,以减轻服务器压力。

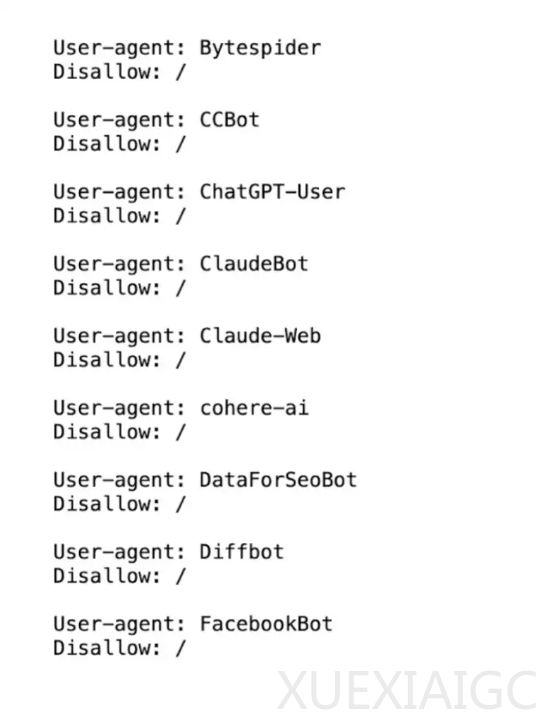

这一问题引起了众多开发者的共鸣。他们发现,更新robots.txt文件后,爬虫的抓取尝试次数反而增加了10倍。一些网站如iFixit和Read the Docs也遭受了类似的困扰。面对这一问题,一些开发者开始采取“报复”措施,如开发WordPress插件AI Poison Pill,扰乱爬取内容,或者将爬虫重定向到返回大量数据的页面,浪费爬虫公司的资源。

新闻媒体也是爬取的重灾区。Palewire项目检查了1158家新闻出版商,发现超过半数选择了屏蔽爬虫。然而,使用robots.txt作为版权保护方法的法律地位仍有争议。一方面,大语言模型可以通过简单的复制粘贴获取网站内容,打破robots.txt的防御。另一方面,出版机构是否真的愿意拒绝模型开发者使用其内容进行训练,以及是否有足够的勇气屏蔽所有访问活动,仍是未知数。

AI爬虫引发的版权问题日益严重。一方面,有人认为AI爬虫窃取艺术家的作品,抽取其价值,与原创作品竞争,这是不公平的。另一方面,也有人指出,AI工具可以帮助更多人创作原创音乐,而唱片公司却认为这会威胁到自己的市场份额。这场争论的最终结果,可能需要法官来裁决。

原文和模型

【原文链接】 阅读原文 [ 2726字 | 11分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆