文章摘要

【关 键 词】 人工通用智能、规模效应、数据挑战、性能基准、算法进步

本文探讨了大型语言模型(LLMs)规模扩大对实现人工通用智能(AGI)的影响。文章通过虚构的坚信者和质疑者之间的辩论,分析了规模扩大的有效性和潜在挑战。

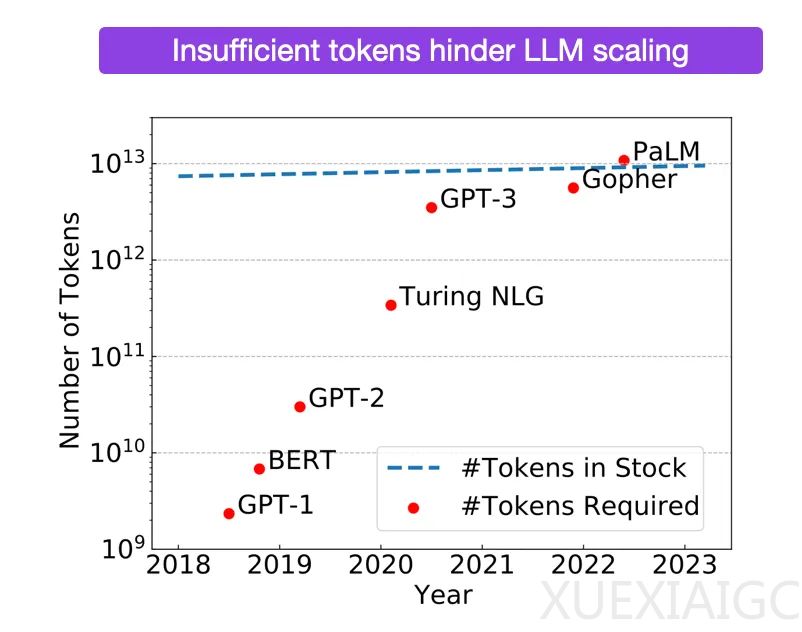

质疑者认为,要构建一个能撰写科学论文的智能AI,需要的数据量是目前的10万倍,而现有技术无法提供指数级的数据增长以匹配计算能力的提升。他们指出,自我对弈/合成数据面临评估和计算两大挑战,且LLMs需要惊人数量的数据才能实现平庸的推理能力,表明它们没有实现泛化。

坚信者则认为,如果规模效应起作用,那么通过扩大Transformer++的规模就能创造出AGI。他们强调,LLMs的“效率低下”主要是由于训练数据和损失函数与实际任务不相关。坚信者还指出,AI的进展简单易行,合成数据可能发挥作用,且基础模型足够强大时,强化学习(RL)变得更加可行。

文章还讨论了性能基准测试,坚信者认为性能已持续提升8个数量级,而质疑者则认为这些测试主要测量记忆和插值,而非智力或创造力。质疑者指出,性能似乎已达到平台期,且常用基准无法衡量长期任务的表现。

坚信者提出,如果深度学习和LLM存在基本上限,那么在发展常识、早期推理和跨抽象思考的能力之前就应该看到这一点。他们还提到,GPT-4的表现突破了对联结主义和深度学习的批评,并认为如果存在硬性上限,那么在发展更高级推理之前就应该显现。

最后,作者个人倾向于坚信者的观点,认为70%的可能性是通过规模扩大、算法进步和硬件进步在2040年实现AGI,而30%的可能性是质疑者正确,LLMs和其他类似方法可能失败。作者也提到,可能存在未知的关键证据,因为人工智能实验室没有发布那么多研究成果。

附录中,作者提出了两个额外的考虑点:模型是否会获得基于洞察力的学习,以及灵长类动物的进化是否提供了规模化的证据。质疑者对这两个问题持怀疑态度,而坚信者则认为模型可能会发展出更高效的元学习方法,并且人类大脑的神经元数量与其他灵长类动物相比具有更好的扩展性。

原文和模型

【原文链接】 阅读原文 [ 8113字 | 33分钟 ]

【原文作者】 AI前线

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★