大模型是否有推理能力?DeepMind数月前的论文让AI社区吵起来了

文章摘要

【关 键 词】 深度学习、国际象棋、Transformer、AlphaZero、AI策略

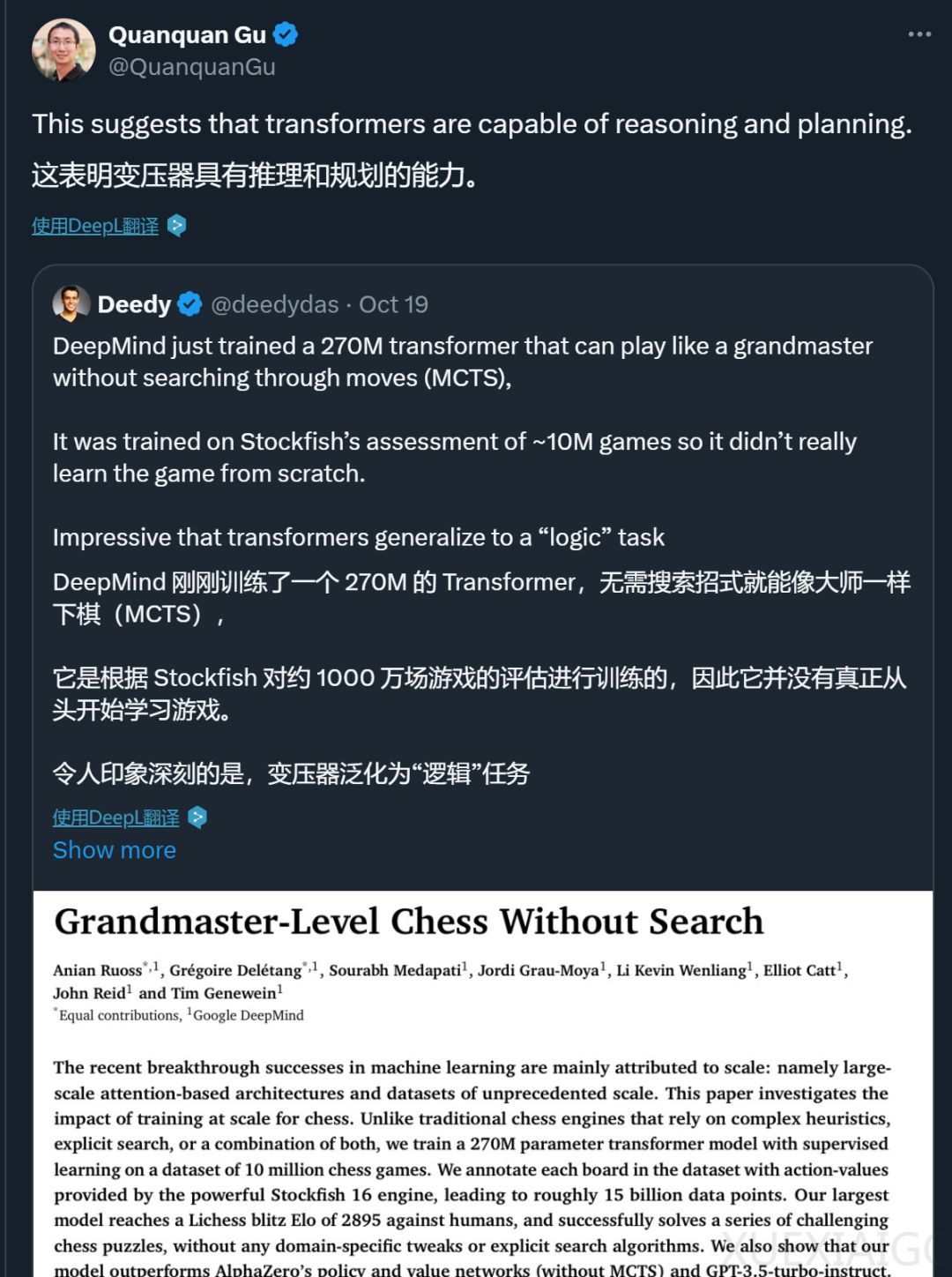

最近,谷歌DeepMind的一篇论文《Grandmaster-Level Chess Without Search》引发了广泛关注。该论文介绍了一个参数量为2.7亿的Transformer模型,该模型无需依赖复杂的搜索算法或启发式算法,就能达到特级大师级的国际象棋水平,优于AlphaZero的策略和价值网络(不含MCTS)以及GPT-3.5-turbo-instruct模型。

这一结果非常有趣,因为到目前为止,能达到这个级别的计算机国际象棋系统都使用了搜索组件。而DeepMind模型不依赖搜索似乎就能达到如此强大的下棋水平。很多人将其解读为:这表明Transformer不是简单的“随机鹦鹉”,而是具有一定的推理和规划能力。论文作者也在结论部分写道:“我们的工作为快速增长的文献增添了新的内容,这些文献表明,复杂而精密的算法可以被蒸馏为前馈transformer,这意味着一种范式的转变,即从将大型transformer视为单纯的统计模式识别器,转变为将其视为通用算法近似的强大技术。”

不过,这种解读也引来了一些争议。比如,Meta FAIR研究科学家主任田渊栋指出,论文采用的评估方法——“blitz”可能存在一些局限。在这种棋赛中,对局每方仅有几分钟的时间思考,玩家往往依赖直觉而非深入的搜索和解决问题的能力。此外,模型与机器人对弈时的分数比与人类对弈时的分数要低。田渊栋认为这可能是因为人类在有限的时间内可能没有机器人那么擅长发现战术上的失误。所以,这种比赛可能并不足以用来测试模型是否拥有推理能力。

纽约大学教授Gary Marcus也认为论文的结论被夸大了,模型的泛化能力存在严重问题。实际上,在今年2月份论文刚出来的时候,就有一些研究者写过关于该论文的质疑文章。

论文的主要研究问题是:是否有可能利用监督学习来获得一种国际象棋策略,这种策略能很好地泛化到新棋局,而不需要显式搜索?为了研究这一问题,作者将大规模通用监督训练的成功秘诀应用于国际象棋。作者使用基于注意力的标准架构和标准监督训练协议来学习预测棋盘的动作-值(action-value,对应胜率)。由此产生的国际象棋策略的强度完全取决于底层行动值预测器的强度。

为了获得大量“真实”动作-值的数据库,作者使用Stockfish 16作为预言机,对数百万个棋盘状态进行注释,这些棋盘状态来自lichess.org上随机抽取的人类对弈棋局。这将产生一个强大的特级大师级国际象棋策略(在Lichess平台上的闪击战中,该模型对阵人类玩家的Elo评分为2895分)。该策略由一个当代transformer驱动,无需任何显式搜索即可预测动作-值。该策略优于GPT-3.5-turbo-instruct(也优于GPT-4)和AlphaZero的策略和价值网络,后者的Elo评分分别为1755、1620和1853。

这项工作表明,通过标准监督学习,有可能在足够大的规模上将Stockfish 16的良好近似值蒸馏到前馈神经网络中。论文的主要贡献是证明了在国际象棋这一领域,成功的策略可以不依赖复杂的算法推理(搜索、动态规划)和复杂的启发式规则,而是可以通过大规模通用监督训练来获得。这为未来在其他需要复杂推理和规划的领域应用类似技术提供了可能性。

原文和模型

【原文链接】 阅读原文 [ 2783字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★★