Transformer继任者「Titans」来了,上下文记忆瓶颈被打破

文章摘要

【关 键 词】 AI架构、注意力机制、长上下文、神经记忆、性能提升

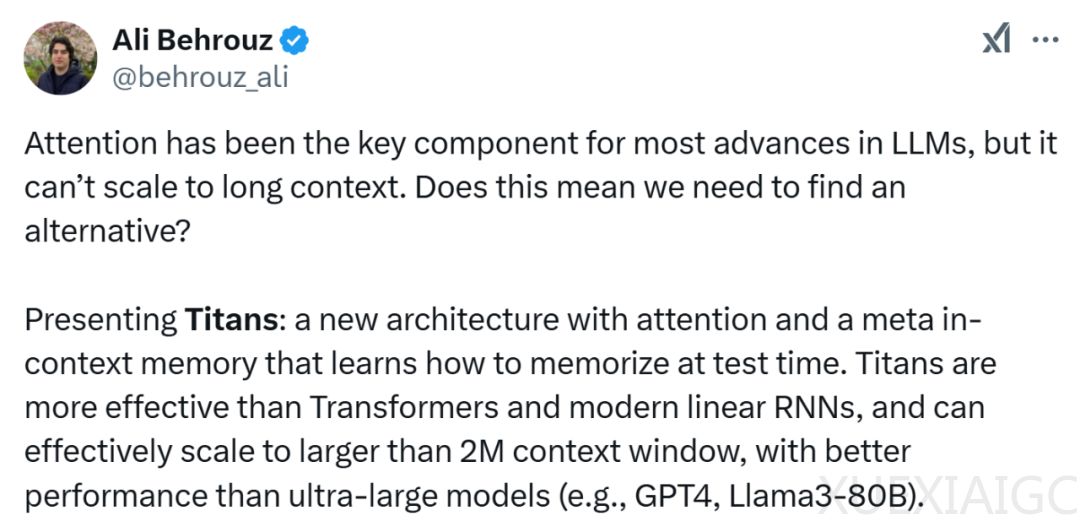

谷歌推出了一种新的AI架构——Titans,旨在解决现有注意力机制无法扩展到长上下文的问题。Titans结合了注意力机制和元上下文记忆,能够处理长达200万tokens的上下文窗口,被视为Transformer架构的“继任者”。该架构通过长期神经记忆模块学习记忆历史上下文,并帮助注意力机制处理当前上下文。实验结果表明,Titans在语言建模、常识推理、基因组学和时序预测任务上比Transformer和现代线性循环模型更有效,特别是在处理超过200万tokens的上下文窗口时,实现了更高的准确性。

Titans架构包含三种变体:记忆作为上下文(MAC)、记忆作为门(MAG)和记忆作为层(MAL),它们通过不同的方式将记忆融合到系统架构中。谷歌还详细介绍了长期神经记忆模块的设计,包括学习测试时记忆、意外指标、遗忘机制、记忆架构和检索记忆等关键技术。此外,谷歌探讨了如何并行化长期记忆训练,以充分利用硬件加速器。

在实验部分,谷歌评估了Titans变体在不同任务上的表现,包括语言建模、常识推理、时序预测和DNA建模。结果显示,Titans在这些任务上均优于现有序列模型。谷歌还比较了Titans与现有SOTA序列模型的效率,发现Titans(MAL)比基线和神经记忆模块都要快。

总体而言,谷歌的Titans架构通过结合注意力机制和长期神经记忆模块,有效扩展了模型处理长上下文的能力,并在多个任务上取得了优于现有模型的性能。这一成果为设计更有效且高效记忆数据的神经架构开辟了新的研究方向。

原文和模型

【原文链接】 阅读原文 [ 4393字 | 18分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆