NYU教授公布2025机器学习课程大纲:所有人都在追LLM,高校为何死磕基础理论?

文章摘要

【关 键 词】 机器学习、课程设计、基础理论、随机梯度下降、经典论文

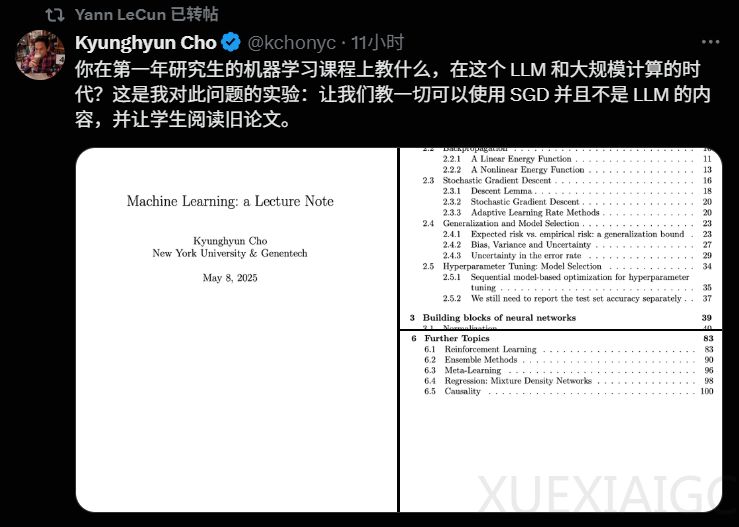

Meta公司首席AI科学家LeCun转发了其同事Kyunghyun Cho关于2025学年机器学习研究生课程的教学大纲和讲义。该课程以随机梯度下降(SGD)为核心,避开大型语言模型(LLM),鼓励学生研读经典论文,回溯机器学习理论发展。与斯坦福、MIT等高校的课程相似,基础理论和经典模型仍是研究生课程的核心。例如,斯坦福CS229课程系统讲授线性回归、逻辑回归、SVM等基本模型,强调数学推导与优化思想。MIT的6.790课程则从概率建模和统计推理角度深入理解机器学习方法。清华电子系也设置了《机器学习》《统计推断理论和方法》等核心理论课程。而LLM内容多在专门选修课中出现,如斯坦福CS25: Transformers United。

教育界普遍认为基础教学有助于学生长远发展。Cho在讲义中引用Sutton的「苦涩教训」,强调通用可扩展方法比具体架构更重要。他刻意省略复杂体系,专注于历史上成熟的算法和数学直觉,认为一个学期时间不足以深入所有主题,只能先打下坚实基础。Cho曾在博客中提到,2010–2015年间深度学习尚未普及时,很多ML课程对神经网络仅作简单提及。如今通过强调经典方法、阅读经典论文,可以让学生理解知识的源头与演进脉络,培养批判性思考能力。总体而言,基础导向的教学能让学生掌握算法背后的数学原理和优化方法,而不是「盲目套用」最新模型。

大学培养机制强调基础、原理和科研能力,而实际工作环境尤其在工业界常常需要快速响应、工程落地、产品迭代能力。对此不少大学也在积极探索解决方案,为弥补科研与工程能力脱节,不少学校推出了「桥接」课程或实践项目。例如,斯坦福大学在开设CS229等理论课的基础上,还专门设立了CS329S《机器学习系统设计》实践课。CMU的机器学习博士生必须修读10-718《机器学习实践》课程。国内高校也开始重视实践教学。清华大学电子系与企业合作开设了多门实用性课程,如「大数据技术的应用与实践」、「高阶机器学习」和「智能制造」等,将行业实际案例和编程实践引入教学过程。

在当今技术飞速发展的背景下,许多高校依然强调「打好基础、追求深刻理解」,这并非单纯的「固步自封」。真正的技术能力不仅在于「会用工具」或「能跑模型」,而在于理解方法背后的原理,在面对新问题、新技术时,具备独立分析、判断和创造的能力。吴恩达曾在一篇文章中以个人经历说明持续学习基础知识的重要性,他强调「牢靠且及时更新的基础知识是成为一名高产机器学习工程师的关键」。这种理念的核心在于「抗变化性」。技术潮流更新迅速,从CNN到Transformer,再到LLM和多模态系统,每一步都可能颠覆现有工程范式。要适应这些变化,不能仅靠追逐热点,而需深入掌握优化、泛化、表示学习等底层理论。只有理解「为何这样设计」以及「背后的假设是什么」,才能在面对全新技术时避免迷茫。

深度学习教父、图灵奖得主Geoffrey Hinton指出,正是对基础算法的长期坚持和深入研究,才推动了深度学习的突破。基础知识的积累和理解,是AI领域每一次重大进步的根本。当然,这种教育路径并非忽视实践,而是强调:真正的实践力应建立在理解力之上。不仅要会用工具,更要了解其来龙去脉、适用边界与改进方向。因此,「找工作」与「打基础」并非非此即彼的选择题,而是时间维度上的权衡。短期内,工具技能能带来直接的岗位匹配;但长期来看,基础能力才是跨越技术周期、持续成长的「护城河」。

课程讲义对机器学习进行了全面介绍,涵盖了基础概念和现代技术。每一章的结构和内容概要如下:第一章介绍能量函数作为机器学习中的统一主题的概念。第二章涵盖基本的分类算法,包括感知器、边际损失、softmax和交叉熵损失。第三章探索了神经网络架构中常用的构建块。第四章说明了如何从概率角度解释能量函数。第五章探索无向生成模型,重点介绍受限玻尔兹曼机(RBMs)和专家乘积(PoE)。第六章提供了机器学习中几个高级主题的概述。

最后,Cho提到的经典论文包括REINFORCE算法、高效反向传播、对比散度算法、变分自编码器(VAE)和MAML(Model-Agnostic Meta-Learning)。这些论文在机器学习领域具有开创性意义,奠定了现代方法的基础。

原文和模型

【原文链接】 阅读原文 [ 2886字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-v3

【摘要评分】 ★★★★★