作者信息

【原文作者】 量子位

【作者简介】 追踪人工智能新趋势,关注科技行业新突破

【微 信 号】 QbitAI

文章摘要

【关 键 词】 Mamba、Transformer、S4架构、可选性、快速训练

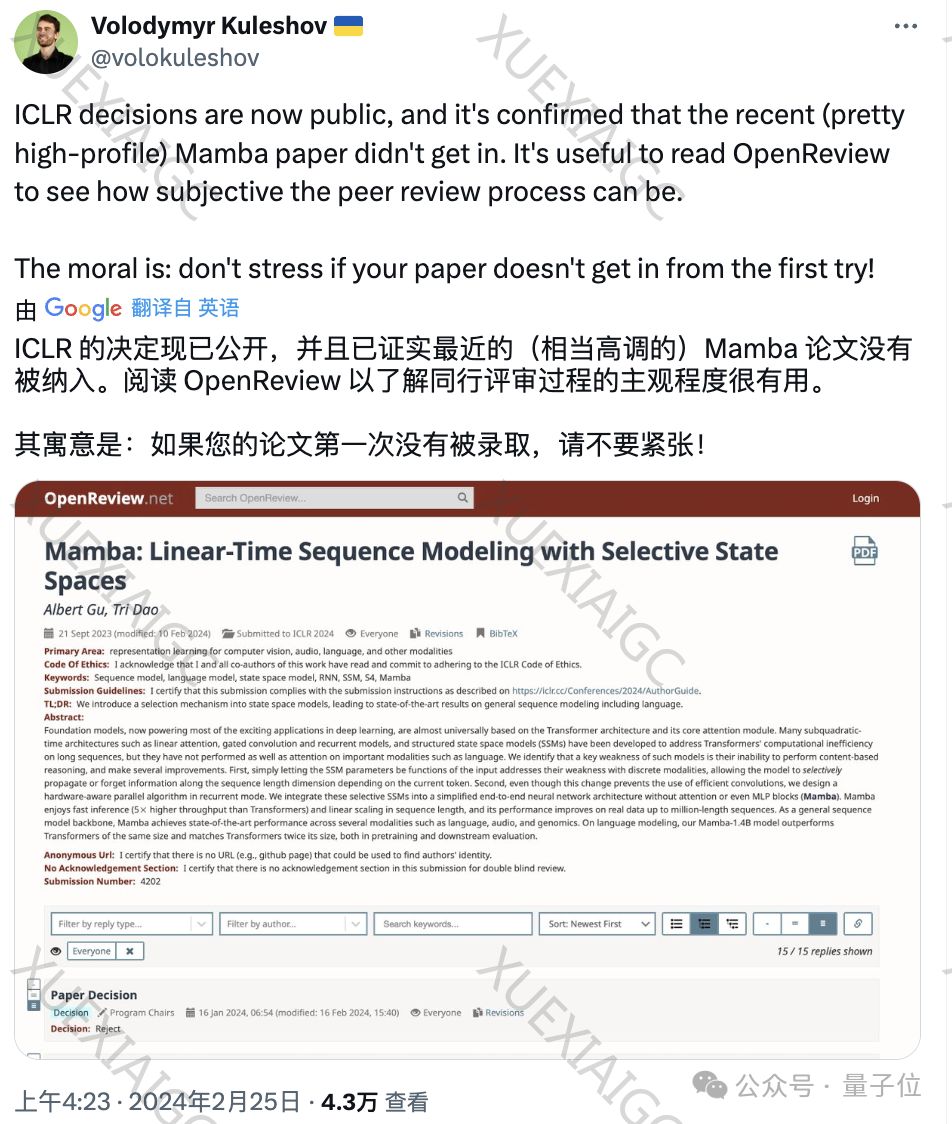

Mamba,这个被寄予厚望的Transformer挑战者,尽管在学术界引起了广泛关注,但最终还是被ICLR会议拒绝。

尽管如此,Mamba的热度并未受到影响,一篇关于它的最新通俗解读文章受到了网友们的热烈欢迎。

Mamba的架构基于S4,这是一种状态空间模型(SSM)架构,它通过中间状态将输入映射到输出。

S4的特点是能够处理连续数据,如音频、传感器数据和图像,并且可以通过离散化处理离散数据,如文本。

Mamba的核心在于其可选性,即模型参数可以根据输入而变化,这使得模型能够专注于输入中对当前任务更重要的部分。

然而,这种选择性带来了训练速度慢的问题。

为了解决这个问题,Mamba的作者提出了一种无需卷积的快速训练方法,通过并行扫描算法来加速RNN模式下的训练。

在多个序列建模任务上,Mamba展现出了优秀的性能,尤其是在语言建模方面。

尽管Mamba在ICLR会议上遭遇了“二连拒”,但其创新性和潜力仍然得到了学术界的认可。

时间可能会证明Mamba的价值,就像Word2vec一样,尽管最初被拒绝,但最终获得了NeurIPS的时间检验奖。

原文信息

【原文链接】 阅读原文

【原文字数】 2955

【阅读时长】 10分钟

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...