LLM最大能力密度100天翻一倍!清华刘知远团队提出Densing Law

文章摘要

【关 键 词】 AI发展、大模型、Densing Law、算力提升、模型小型化

近期AI领域关于大模型的Scaling Law是否已达到极限产生了分歧。一方面,有人认为Scaling Law已撞墙;另一方面,如OpenAI CEO Sam Altman等认为Scaling Law潜力未尽。争论核心在于大模型性能提升是否还能靠无限堆叠数据和参数规模。

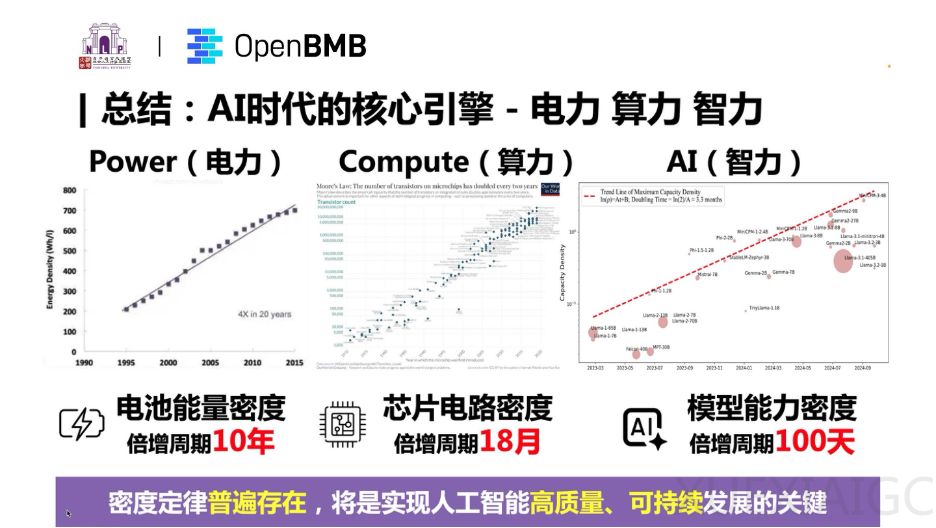

清华大学刘知远教授团队提出了大模型的Densing Law,即模型能力密度随时间呈指数级增长,每约100天翻一倍。这意味着每100天,我们可以用一半参数量实现当前最优模型相当的性能。Densing Law还揭示了AI时代三大核心引擎——电力、算力与智力,都同样遵循密度快速增长趋势。

Densing Law的主要推论包括:1)模型推理开销随时间指数级下降;2)大模型能力密度正在加速增强;3)模型小型化揭示端侧智能巨大潜力;4)无法仅靠模型压缩算法增强模型能力密度;5)模型高性价比有效期不断缩短。

该定律还指出,未来应持续探索大模型科学化建设路径,不断改进模型制造工艺,实现大模型的高质量、可持续发展。相关研究成果可参考论文《Densing Law of LLMs》。

Densing Law揭示了LLM进入”密度至上”的新发展阶段。在尺度定律下,LLM规模至上;而在密度定律下,LLM正进入一个全新的发展阶段。AI时代的三大核心引擎——电力、算力与智力,密度都在快速增长。模型能力密度的提升意味着用更少的资源实现更强的能力,为AI技术的可持续发展提供了无限可能,也揭示了端侧智能的巨大潜力。在这一趋势下,AI计算从中心端到边缘端的分布式特性协同高效发展,将实现”AI无处不在”的愿景。

原文和模型

【原文链接】 阅读原文 [ 2127字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆