Kimi官方复盘:k1.5复现o1的思考过程

文章摘要

【关 键 词】 多模态思考、Long CoT、RL训练、In Context RL、AGI展望

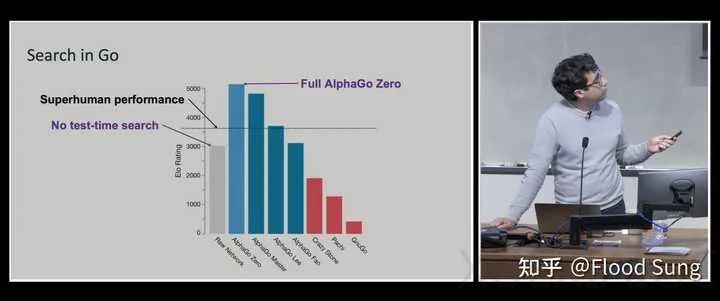

Kimi的多模态思考模型k1.5发布后,技术人员在知乎上分享了复现o1的关键思考过程。他们首先认识到Long CoT的有效性,并反思了Long Context的重要性。尽管Long CoT成本高、速度慢,但为了提升性能,他们决定投入研究。通过观察o1官网的例子,他们发现o1可以犯错、反复反思并尝试不同的思考方法。两个重要的openai视频进一步启发了他们,特别是Noam Brown强调Test-Time Search的重要性,而Hyung Won Chung的视频则强调了不限制模型思考的重要性。

他们得出结论,Agentic Workflow只有短期价值,最终会被模型本身的能力取代。他们的目标是训练模型像人类一样自由思考。Noam Brown的另一张PPT强调了进行有精确Reward的RL的重要性,而不是被Reward Model限制。他们认为,通过RL训练LLM通过Long CoT做题是关键,而不是采取结构化的方法。

o1实际上是In Context RL with Self-Critique,将完整的trajectory作为一条message进行训练。他们发现,模型会随着训练提升performance而增加token数,这是RL训练过程中模型可以自己涌现的。他们将问题转化为Contextual Bandit问题,并使用REINFORCE的变种进行训练。

最后,他们认为AGI确实近在眼前,而ASI则是RL在更复杂场景的应用。他们期待AI在各种领域的进展,并对未来充满期待。

原文和模型

【原文链接】 阅读原文 [ 2774字 | 12分钟 ]

【原文作者】 Founder Park

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆