DeepSeek V3+R1满血微调工具上线!一键启动,硬件要求降10倍

文章摘要

【关 键 词】 大模型训练、后训练工具、低成本微调、强化学习、硬件兼容

DeepSeek V3/R1等大模型在开源社区广泛应用的背景下,如何通过后训练技术实现低成本、高质量的私有模型定制成为行业焦点。Colossal-AI推出的开源大模型后训练工具箱为此提供了系统化解决方案,其核心功能覆盖监督微调、强化学习工具链及硬件适配等多个维度。该工具集支持包括DeepSeek V3/R1 671B在内的多种模型,通过LoRA技术显著降低训练成本,可将硬件需求缩减近10倍,支持32个Ascend 910B NPU或24个H100/H800 GPU完成训练。

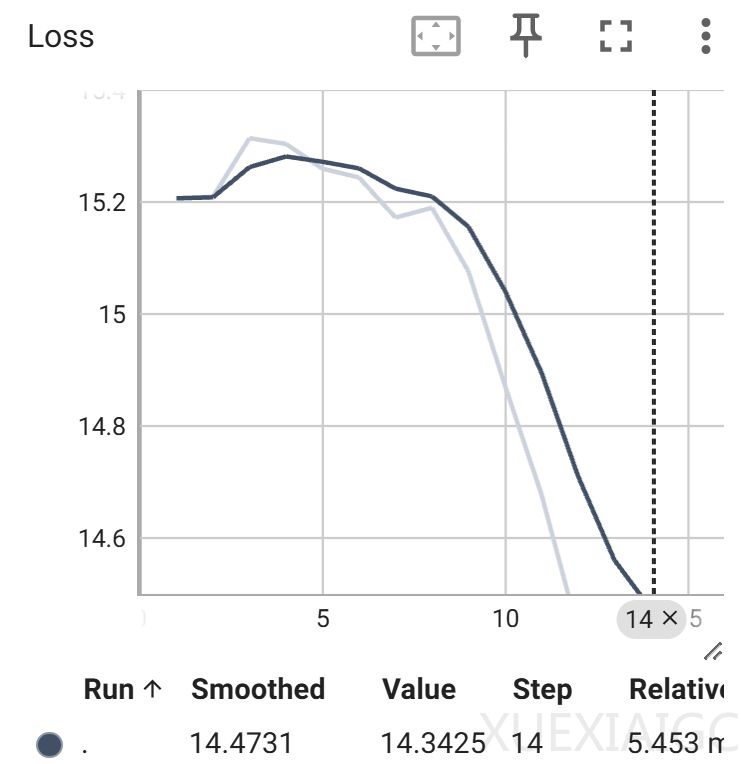

监督微调流程包含数据集准备、权重转换和训练执行三个关键环节。JSONL格式的对话数据集兼容HuggingFace模板,允许自定义系统提示。针对不同硬件平台,提供BF16权重转换脚本以确保微调效果,并通过一键启动脚本实现参数化配置,支持混合精度训练、梯度检查点等优化技术。训练过程中可实时监控学习率、损失值等指标,支持ep=8,pp=3的混合并行策略,有效平衡计算资源与训练效率。

在硬件优化方面,工具链通过LoRA参数高效微调技术突破算力限制。结合Zero CPU Offload技术可进一步降低硬件门槛,同时保持训练稳定性。对于大规模训练需求,系统支持扩展至数千卡集群进行全参数微调,为不同预算团队提供灵活选择。

强化学习模块创新性地实现了GRPO算法与可验证奖励机制。基于Qwen2.5-3B-Base模型的实验显示,奖励函数设计能有效驱动模型自我优化,通过三阶奖励机制(0/1/10)引导格式正确性与内容准确性的同步提升。训练过程中观察到平均奖励与回复长度的同步增长,以及模型自我纠正能力的显著增强,验证了该方案在小模型场景下的可行性。

该工具箱强调开箱即用特性,支持自定义奖励函数、并行策略和硬件适配,覆盖从数据预处理到模型部署的全流程。通过提供标准化接口与模块化设计,既满足专业团队的大规模训练需求,也为中小开发者提供了低门槛的定制化路径。其开源生态已积累近4万GitHub Star,持续推动大模型后训练技术的普惠化应用。

原文和模型

【原文链接】 阅读原文 [ 1305字 | 6分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆