文章摘要

【关 键 词】 开源工具、模型微调、硬件兼容、训练优化、强化学习

Colossal-AI团队近期推出开源大模型后训练工具箱,为开发者提供低成本构建私有模型的解决方案。该工具箱支持对DeepSeek-V3/R1-671B等大模型进行全流程优化,通过LoRA技术将6710亿参数模型的微调硬件需求降低近10倍,最低仅需24块H100/H800 GPU或32块华为昇腾910B NPU即可运行。

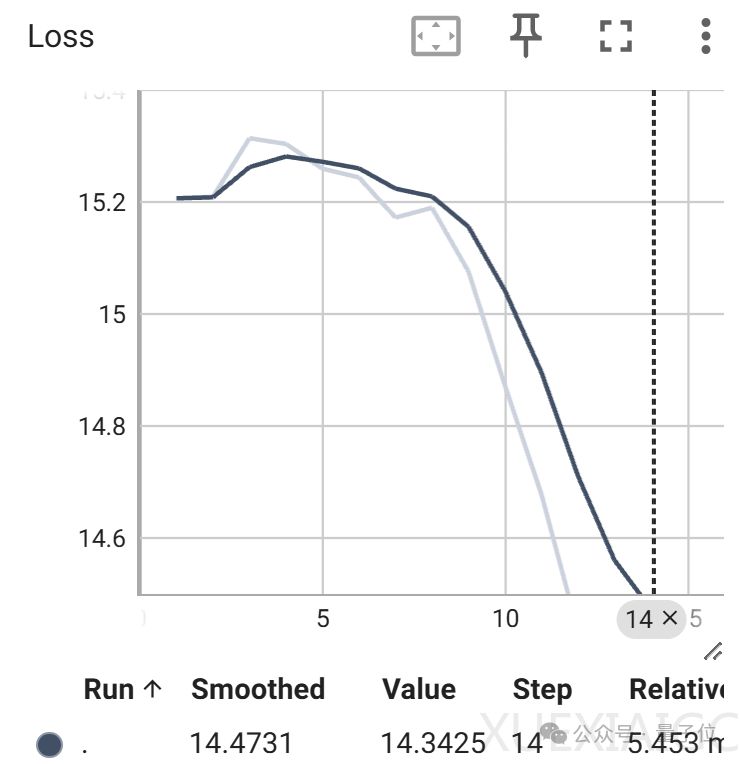

监督微调功能支持完整的操作流程,包含数据集预处理、权重格式转换和分布式训练配置。系统兼容JSONL格式数据集,允许自定义对话模板与系统提示,通过BF16权重转换脚本有效提升微调效果。训练过程中支持混合精度、梯度检查点等技术,配合数据/模型/专家并行策略,实现计算资源的高效利用。工具链还内置TensorBoard监控模块,可实时追踪学习率、损失值等关键指标。

在强化学习领域,该工具箱整合了PPO、GRPO、DPO等多种算法,并创新性地实现可验证奖励机制。实验显示,使用Qwen2.5-3B模型验证GRPO算法时,模型在训练过程中展现出自我纠正能力,平均奖励值与回复长度随迭代次数同步增长。奖励函数设计采用三级评分体系,允许开发者根据具体场景灵活定制评估标准。

硬件兼容性方面,系统同时支持英伟达GPU与华为昇腾NPU生态,针对国产算力平台提供专门的权重转换脚本。通过Zero-CPU Offload技术可进一步降低显存占用,为资源有限的团队创造可行性。对于具备充足算力的机构,工具箱支持扩展到数千卡规模的分布式训练,实现全参数微调加速。

该开源项目已获得近4万GitHub星标,其模块化设计允许开发者快速适配HuggingFace生态中的各类模型。通过提供从监督微调到强化学习的完整工具链,Colossal-AI正在成为大模型产业落地的关键基础设施,助力企业以较低成本构建具备业务特色的私有化模型。项目开源地址为https://github.com/hpcaitech/ColossalAI,持续更新各类训练案例和技术文档。

原文和模型

【原文链接】 阅读原文 [ 1224字 | 5分钟 ]

【原文作者】 量子位

【摘要模型】 deepseek-r1

【摘要评分】 ★★★☆☆