CLIP 后门样本检测:揭示网络数据集中的后门风险丨ICLR 2025

文章摘要

【关 键 词】 后门检测、多模态模型、异常分析、预训练安全、数据清洗

多模态模型的安全问题因后门投毒风险引发关注,尤其是CLIP模型在视觉-语言对齐任务中的广泛应用。研究表明,攻击者仅需对0.01%的训练数据投毒即可植入后门,通过特定触发器操控模型输出,其低成本和高隐蔽性对实际应用构成威胁。墨尔本大学、复旦大学与新加坡管理大学的研究团队提出了一种面向工业场景的大规模数据集轻量化后门检测方法,仅需4卡A100即可在5分钟内清洗一百万条图文数据。该方法通过分析CLIP模型嵌入空间中样本的局部邻域密度差异,实现了高效检测。

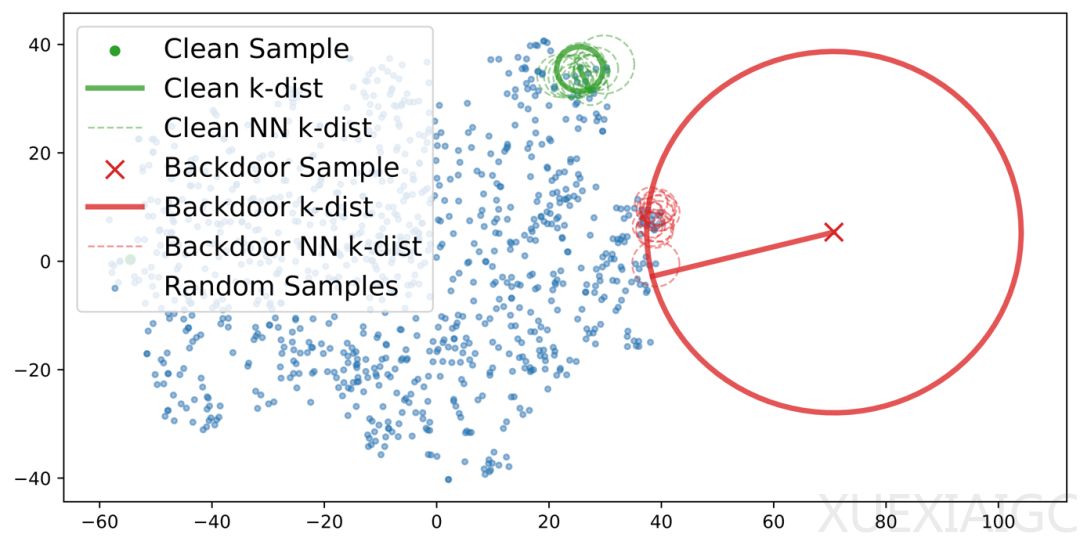

通过t-SNE可视化分析发现,后门样本在嵌入空间中呈现局部邻域稀疏特性,与干净样本的密集聚集形成显著对比。基于此,研究团队设计了基于局部邻域异常检测的算法,包括k近邻距离(k-dist)、简单局部离群因子(SLOF)和局部内在维度离群因子(DAO)。实验结果显示,这些方法在ROC曲线下面积(AUROC)指标上表现优异,且在不同模型架构、投毒攻击方式下均保持稳定。

在真实数据集验证中,该方法从谷歌CC3M数据集中检测出798个自然存在的后门样本,占数据总量的0.03%,这些样本均包含“数字图标形式的生日蛋糕蜡烛”文字描述。更关键的是,研究团队在OpenCLIP开源预训练模型中逆向提取出后门触发器,其攻击成功率在ImageNet零样本分类任务中达到98.8%,证实后门已被植入广泛使用的开源模型。

此外,异常检测还揭示了数据集中的无效样本问题。异常值最高的样本中包含大量空白或失效的“占位”图像,反映出数据维护缺失导致的噪声污染。该方法不仅定位后门样本,还能提升数据集整体质量。研究结果被ICLR 2025接收,为多模态模型安全提供了新的检测范式和实践工具。

原文和模型

【原文链接】 阅读原文 [ 2404字 | 10分钟 ]

【原文作者】 AI科技评论

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★☆