谷歌10M上下文窗口正在杀死RAG?被Sora夺走风头的Gemini被低估了?

模型信息

【模型公司】 月之暗面

【模型名称】 moonshot-v1-32k

作者信息

【原文作者】 机器之心

【作者简介】 专业的人工智能媒体和产业服务平台

【微 信 号】 almosthuman2014

文章摘要

【关 键 词】 Gemini 1.5 Pro、AI、谷歌、RAG、多模态

Gemini 1.5 Pro 测评摘要:

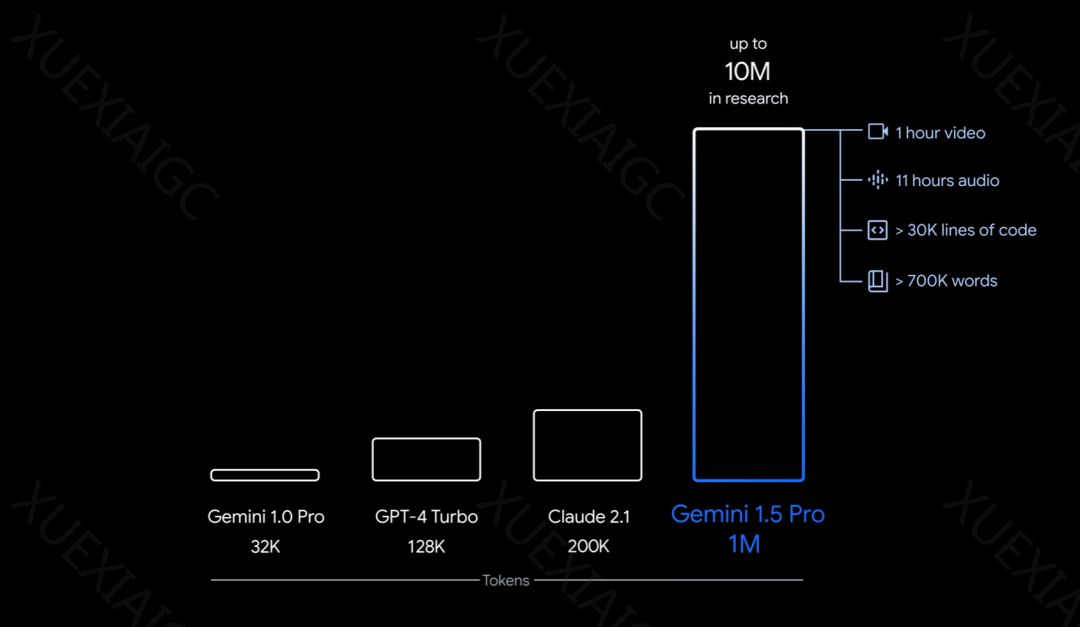

谷歌推出的Gemini 1.5 Pro模型在多模态数据处理方面展现出了显著的能力,尤其是在处理超长上下文方面。该模型能够处理高达100万token的文本,极限为1000万token,这在AI领域是一个突破。Gemini 1.5 Pro不仅在代码理解和修复方面表现出色,还能在没有额外资料的情况下学会小语种翻译,其翻译得分接近人类学习者。

RAG 方法的未来:

Gemini 1.5 Pro的超长上下文处理能力引发了对RAG(检索增强生成)方法必要性的讨论。RAG通常用于在大模型中检索相关信息以指导生成过程。然而,随着Gemini 1.5 Pro等长上下文模型的出现,RAG方法可能变得不那么必要。研究者符尧认为,长上下文模型可以在整个解码过程中混合检索和推理,而RAG仅在开始时进行检索。尽管如此,也有研究者提出反驳意见,认为RAG在特定数据类型和动态信息处理方面仍有其优势。

Gemini 1.5 Pro 的实际应用:

在实际应用测试中,Gemini 1.5 Pro展示了其在长文档分析和视频理解方面的能力。例如,它能够从PDF文件中提取信息并回答问题,以及从视频中提取表格信息。尽管在处理具体细节时可能会出现失误,但模型在理解讲座内容和要点方面表现出色。

结论:

尽管Gemini 1.5 Pro在多模态数据处理方面取得了显著进步,但RAG方法是否将被取代仍有待观察。两者各有优势,未来可能会看到它们在不同场景下的互补使用。

原文信息

【原文链接】 阅读原文

【原文字数】 3592

【阅读时长】 12分钟