统一SAM2和LLaVA!字节豆包提出Dense Video多模态大模型Sa2VA

文章摘要

【关 键 词】 AI模型、多模态学习、视频理解、图像分割、指令微调

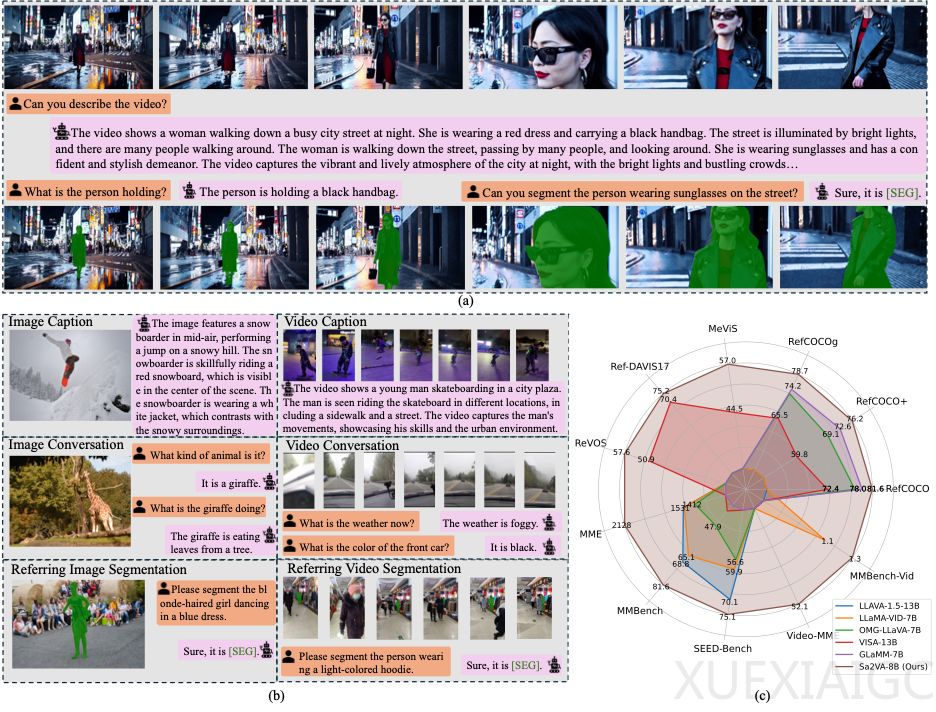

来自字节跳动、北京大学等机构的研究者提出了Sa2VA模型,这是首个结合SAM-2和LLaVA-like架构的视频多模态大模型。该模型通过整合时空细粒度理解能力,实现了对图像和视频的联合感知与推理。其核心创新在于将分割模型SAM-2的视觉处理能力与多模态大语言模型的自然语言交互优势相结合,突破了传统模型在开放世界推理与细粒度感知间的能力鸿沟。

研究团队设计了一套统一的指令微调框架,将图像/视频指代分割、视觉问答、对话生成等五大类任务整合到单一训练流程中。通过将不同模态输入统一编码为令牌序列,模型实现了跨任务的参数共享,仅需单次训练即可支持多种复杂场景应用。特别值得注意的是,模型采用分离式架构设计:多模态语言模型处理语义推理,SAM-2解码器专注分割任务,这种设计既降低了计算开销,又保持了基础模型的可替换性。

在技术实现层面,Sa2VA创新性地引入”[SEG]”令牌作为跨模态交互接口。该令牌的隐藏状态承载时空语义信息,既指导SAM-2生成分割结果,又通过梯度回传优化语言模型的时空理解能力。针对视频处理,模型采用关键帧提取策略,首先生成关键帧分割结果,再通过预训练记忆编码器推导后续帧的分割,有效平衡了计算效率与处理精度。

实验结果表明,Sa2VA在13个公开数据集上的5类任务中均取得领先性能。在视频指代分割任务中,其分割精度相比现有方法提升超过8%,在开放场景测试中展现出强大的泛化能力。研究团队同时发布了Ref-SAM-v新基准,该数据集通过多模态模型自动生成目标级描述,包含更具挑战性的测试场景。可视化案例显示,模型不仅能准确分割电影片段中的特定人物(如《爱乐之城》中的黄裙女性),还能结合场景理解生成情感分析(如解读《教父》中抱猫角色的心理状态)。

实际应用方面,Sa2VA展示了多任务协同处理的潜力。在典型测试案例中,模型可同时完成视频对象定位、场景氛围分析和交互式问答,证明了其在智能视频编辑、影视内容分析等领域的应用价值。研究团队开源了代码和部分预训练模型,为后续多模态研究提供了重要技术参考。

原文和模型

【原文链接】 阅读原文 [ 3271字 | 14分钟 ]

【原文作者】 机器之心

【摘要模型】 deepseek-r1

【摘要评分】 ★★★★★