文章摘要

【关 键 词】 微软研究、小模型、Phi系列、多模态、推理能力

本文介绍了微软在小模型(Small Language Models, SLMs)领域的研究成果,特别是Phi系列模型。随着大模型规模的扩大,训练和运行所需的计算资源日益紧张,小模型因其较小的规模和较低的计算需求,为资源有限的端侧设备提供了解决方案。微软的Phi系列模型证明了即使在较小的模型规模下,也能实现强大的语言理解和生成能力。

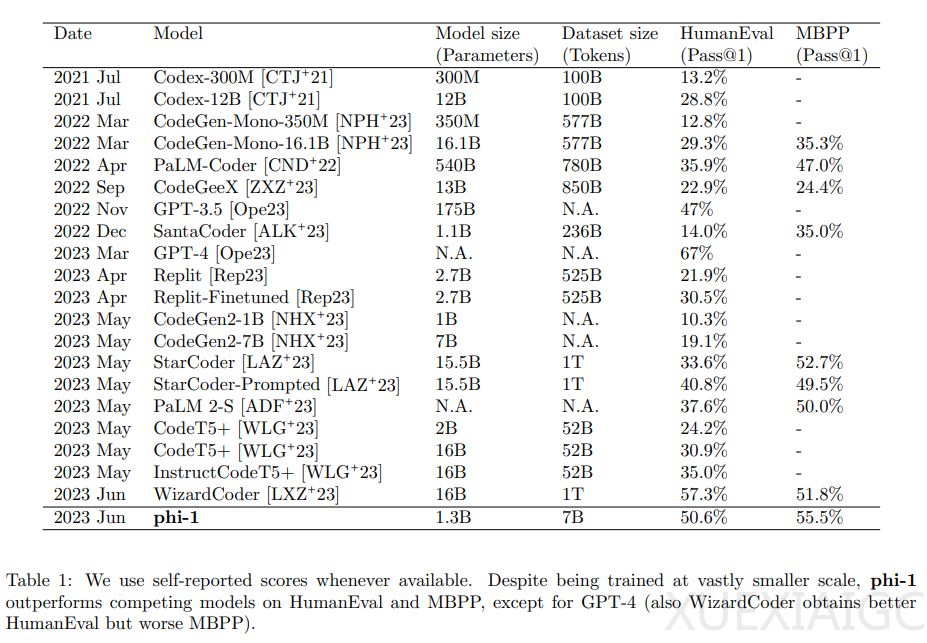

Phi-1模型基于Transformer架构,拥有1.3亿参数,在Python编程任务上展现出接近大型模型的性能。Phi-1.5模型在Phi-1的基础上进行了优化,引入了新数据源,提高了自然语言任务的表现。Phi-2模型通过知识转移技术,提升了性能,并在安全性和偏见方面有所改进。

Phi-3系列包括Phi-3 mini、Phi-3 small和Phi-3 medium三个不同量级的小模型,以及Phi-3-vision多模态模型。Phi-3-mini在学术基准测试中性能接近大型模型,Phi-3-small和Phi-3-medium分别拥有7.0B和14B参数,训练数据量达到4.8万亿和4.9万亿tokens。Phi-3-vision融合了视觉和语言功能,提供了出色的语言和图像推理质量。

Phi-3.5系列包括Phi-3.5-mini、Phi-3.5-MoE和Phi-3.5-vision三个模型,分别针对轻量级推理、混合专家系统和多模态任务设计。Phi-3.5-mini支持快速推理任务,Phi-3.5-MoE采用混合专家架构,Phi-3.5-vision集成了文本和图像处理功能。

文章还介绍了Phi-3.5-vision模型在GPU上的推理部署和测试,展示了其多模态问答能力。胡平博士,微软云人工智能高级专家,专注于AIGC、视觉生成和多模态大模型领域,为企业级客户提供项目架构设计、咨询培训、测试开发支持等服务。

原文和模型

【原文链接】 阅读原文 [ 3320字 | 14分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆