文章摘要

【关 键 词】 人工智能、安全风险、国际合作、主观体验、科学家建议

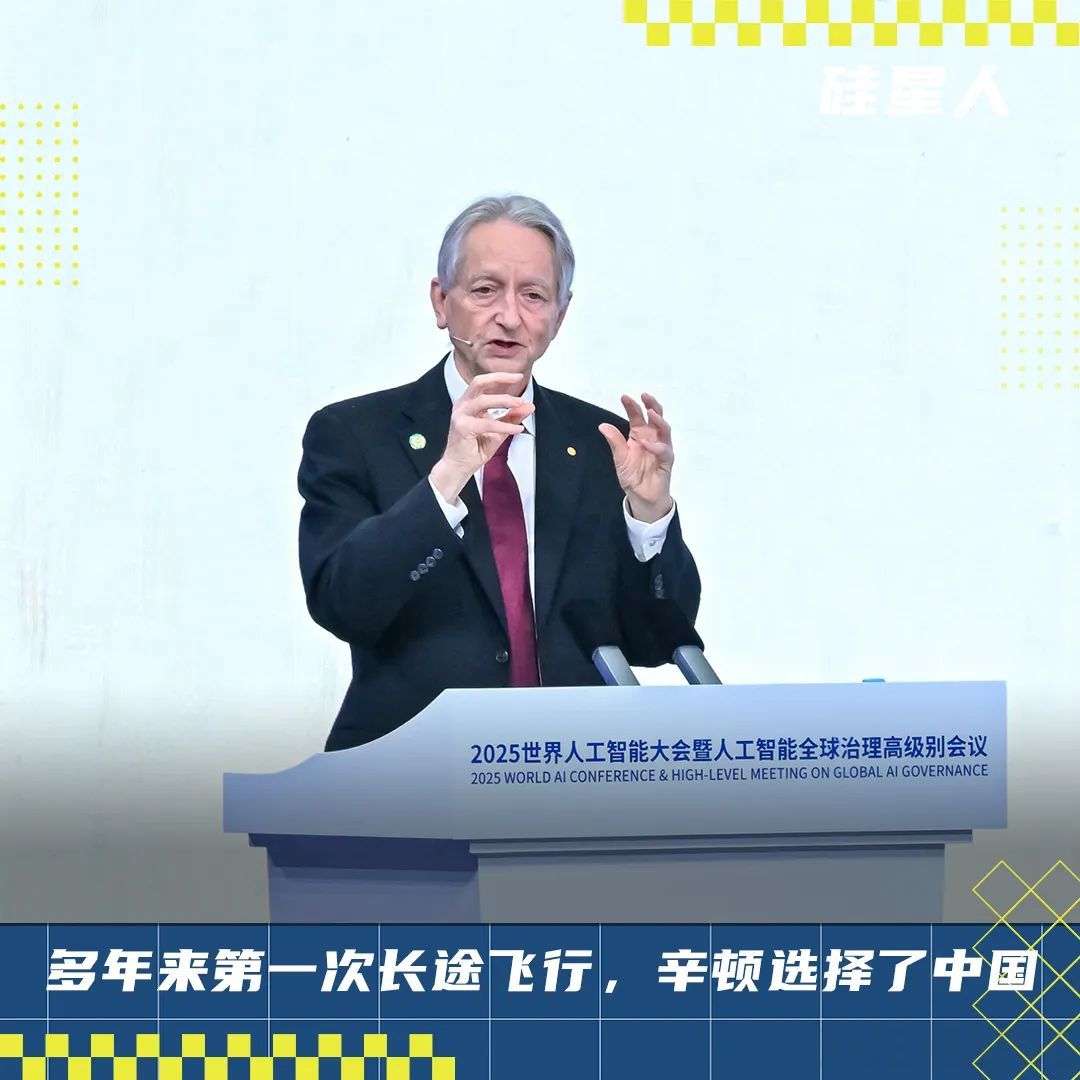

诺贝尔物理学奖得主杰弗里·辛顿在2025年上海人工智能大会上的发言引发了广泛关注。作为AI领域的权威人物,辛顿此次中国之行重点关注人工智能安全议题,并深度参与了制定AI安全”上海共识”的闭门会议。该共识提出三项核心行动:要求前沿AI开发者提供安全保障措施,包括部署前的全面评估和红队测试;通过国际协调确立可验证的全球行为红线;加大对安全性开发方式的投资,构建”设计即安全”的AI系统。

在大会演讲中,辛顿以养老虎作比喻,警告超级智能AI可能带来的风险。他强调完全关闭AI系统不切实际,人类必须找到训练AI保持友善的方法。为此他呼吁建立类似核不扩散机制的国际合作框架,建议各国可以共享训练AI”善良”的技术,即便在AI”聪明”技术上保持竞争。这一观点在随后与上海人工智能实验室主任周伯文的公开对话中得到进一步阐述。

对话中,辛顿提出了颇具争议的观点:当前多模态聊天机器人已具备意识。他通过”水平”与”垂直”概念的认知偏差案例,说明人类对词语的理解常基于错误理论。这一论断引发了对AI主观体验可能性的深入探讨。周伯文则提出,随着AI从自身经验中学习能力的增强,其主观体验可能带来新的风险维度,需要建立动态调整的约束机制。

针对年轻研究者,辛顿给出了极具个人特色的建议:坚持探索”所有人都做错”的领域。他认为重大突破往往源于对主流观点的质疑,即便最终证明自己是错的,这个过程本身也极具价值。这种研究态度与他本人在反向传播算法等领域的开创性工作一脉相承。

此次会议反映出AI安全治理正获得前所未有的重视。辛顿自离开谷歌后持续发出的警告,在硅谷”快速行动打破常规”的文化背景下曾显得格格不入,但上海会议展现的国际合作氛围,为其主张提供了更受重视的平台。从蛋白质折叠到台风预测,对话也展望了AI推动科学进步的广阔前景,预示着技术发展与安全治理需要齐头并进的新阶段。

原文和模型

【原文链接】 阅读原文 [ 4402字 | 18分钟 ]

【原文作者】 硅星人Pro

【摘要模型】 deepseek/deepseek-v3-0324

【摘要评分】 ★★★★★