李飞飞、谢赛宁等探索MLLM「视觉空间智能」,网友:2025有盼头了

文章摘要

【关 键 词】 视觉空间智能、多模态模型、空间推理、AI研究、人类智能

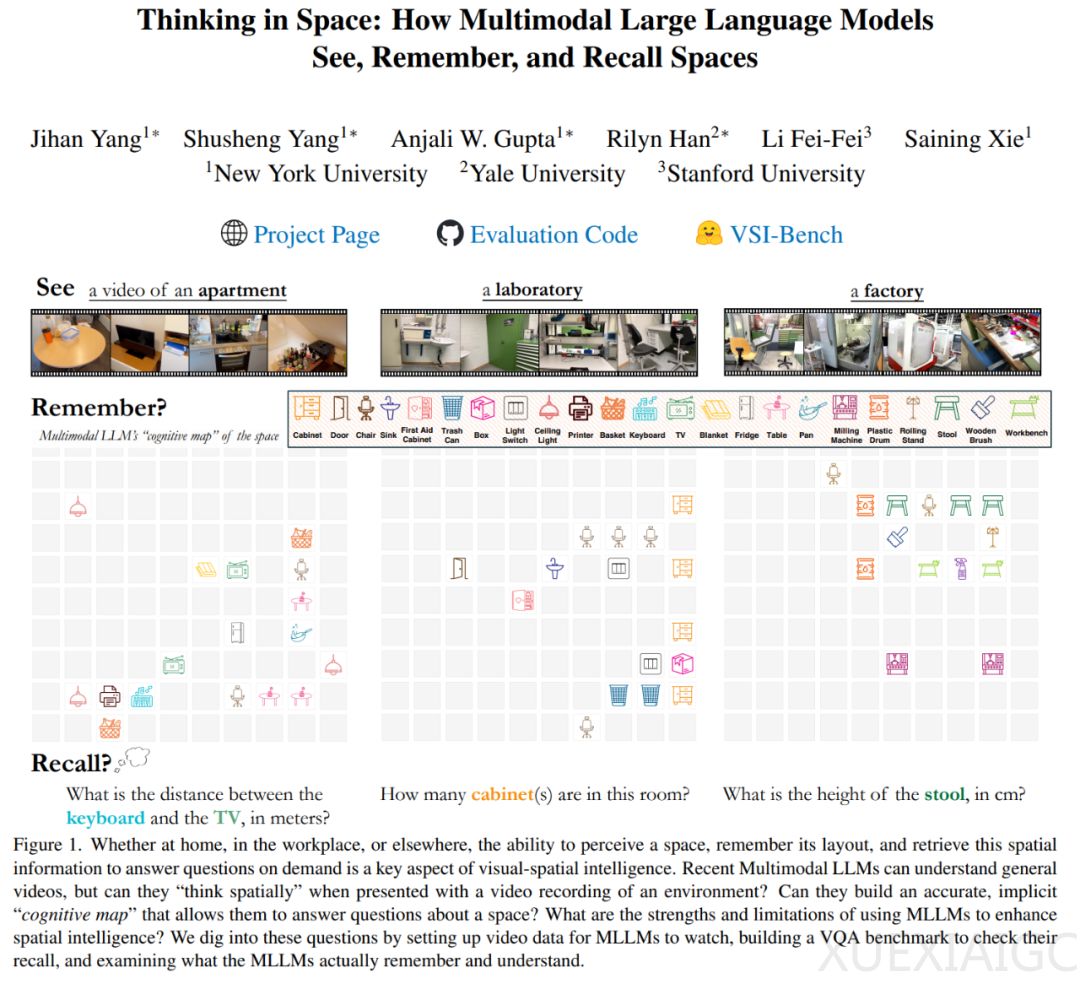

纽约大学、耶鲁大学和斯坦福大学的研究者们提出了VSI-Bench,这是一个基于视频的基准测试,旨在评估多模态大语言模型(MLLM)在视觉空间智能方面的表现。VSI-Bench包含近290个真实室内场景视频和超过5000个问答对,通过连续的时间性输入来模拟人类观察世界的方式,从而丰富空间理解和推理。

评估结果显示,尽管MLLM展现出一定的视觉空间智能,但与人类相比仍有较大差距。人类评估者的平均准确率达到79%,而最佳模型仅为46%。在配置和时空任务上,人类表现接近完美,而MLLM在需要精确估计的测量任务上差距缩小,展现出相对优势。

研究还发现,空间推理是影响MLLM在VSI-Bench上表现的主要瓶颈。71%的错误源于空间推理,尤其是在理解距离、大小和方向方面。此外,语言提示技术在这种情况下反而有害,而MLLM在记忆空间时会形成一系列局部世界模型,而非统一的全局模型。

这项名为”Thinking in Space”的研究,由斯坦福大学教授李飞飞等人领导,旨在评估MLLM在空间推理方面的表现,这对人类智能至关重要。研究者们期待到2025年,AI领域能在空间智能方面取得更多突破。

原文和模型

【原文链接】 阅读原文 [ 2126字 | 9分钟 ]

【原文作者】 机器之心

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...