文章摘要

月之暗面(MoonshotAI)近期对其开源的多模态模型Kimi-VL-A3B-Thinking进行了重大升级,发布了2506版本。这一版本在多个方面实现了显著提升,尤其是在性能表现、视觉理解能力和高分辨率支持上取得了突破性进展。在多模态推理基准测试中,Kimi-VL-A3B-Thinking-2506在MathVision、MathVista、MMMU-Pro和MMMU等任务上分别提升了20.1、8.4、3.2和2.1的准确性,同时平均所需的思考长度减少了20%。这一改进使得模型在推理任务中更加高效且准确。

视觉理解能力方面,2506版本不仅保持了前一版本在思考任务上的优势,还在常规视觉感知与理解任务上表现出色。在MMBench-EN-v1.1、MMStar、RealWorldQA和MMVet等基准测试中,模型的得分分别为84.4、70.4、70.0和78.4,超越了非思考模型Kimi-VL-A3B-Instruct的能力。这表明2506版本在视觉理解方面具备了更全面的实力。

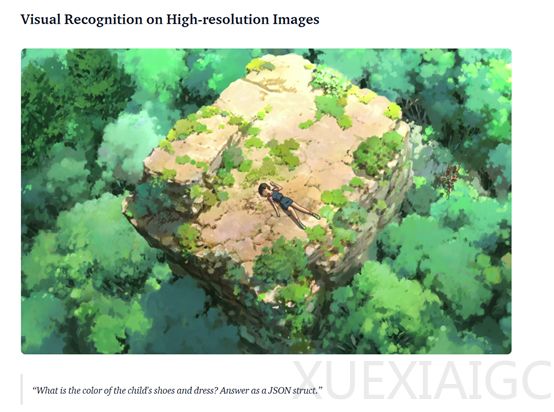

高分辨率支持是2506版本的另一个亮点。模型现在支持单张图像320万总像素(1792×1792),是前一版本的4倍。这一改进使得模型在高分辨率感知和OS-agent接地基准测试中取得了显著进步,如在V*Benchmark、ScreenSpot-Pro和OSWorld-G上的得分分别为83.2、52.8和52.5。这些提升使得模型能够更好地处理高清晰度图像相关任务。

在实际应用中,2506版本在多个领域表现出色,包括图像理解、图表推理、数学计算、OS智能体接地、长PDF理解和视频分析等。例如,在图像理解中,模型能准确识别猫的品种和高分辨率图像内容;在图表推理中,可正确分析不同模型在特定类别下的语义标签准确率;在数学计算里,轻松解决数字填空谜题;在OS智能体接地任务中,精准定位并点击界面元素;在长PDF理解时,深入分析文档内容得出基准测试中的最先进模型及其性能;在视频理解方面,将视频精准拆分为多个场景并详细描述。这些功能展示了模型在多种复杂任务中的强大能力。

Kimi-VL-A3B-Thinking-2506的技术架构主要由MoonViT、MLP投影器和专家混合模型三大块组成。MoonViT作为原生分辨率视觉编码器,能够直接处理不同分辨率的图像,无需借助复杂的子图像分割和拼接操作。它借鉴了NaViT中的打包方法,将图像分割成小块并展平为1D序列,从而与语言模型共享相同的核心计算操作。此外,MoonViT引入了2D旋转位置嵌入,在高度和宽度维度上对细粒度的位置信息进行编码,并结合原始位置嵌入,使得模型能够高效处理不同分辨率的图像。

MLP投影器在视觉编码器和语言模型之间起到了桥梁作用。它通过像素洗牌操作对MoonViT提取的图像特征进行空间维度的压缩,随后将特征投影到与LLM嵌入维度相同的维度上。这一过程确保了视觉特征能够以合适的形式被语言模型接收和处理。

语言模型部分基于Moonlight模型,这是一种28亿激活参数、160亿总参数的专家混合模型。它从Moonlight的预训练阶段的一个中间检查点初始化,并继续使用总计2.3万亿标记的多模态和纯文本数据进行联合预训练。这种联合预训练方式使得模型能够同时提升其语言能力和多模态理解能力。

在优化器方面,Kimi-VL采用了增强版的Muon优化器。该优化器添加了权重衰减,并对每个参数的更新比例进行了精心调整,以实现更优的训练效果。此外,它还开发了遵循ZeRO-1优化策略的Muon优化器分布式实现,提高了内存使用效率,降低了通信开销,为模型的优化提供了有力保障。

总体而言,Kimi-VL-A3B-Thinking-2506在多模态推理、视觉理解和高分辨率支持等方面实现了显著提升,展示了其在多种复杂任务中的强大能力。

原文和模型

【原文链接】 阅读原文 [ 1457字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 deepseek-v3

【摘要评分】 ★★★☆☆