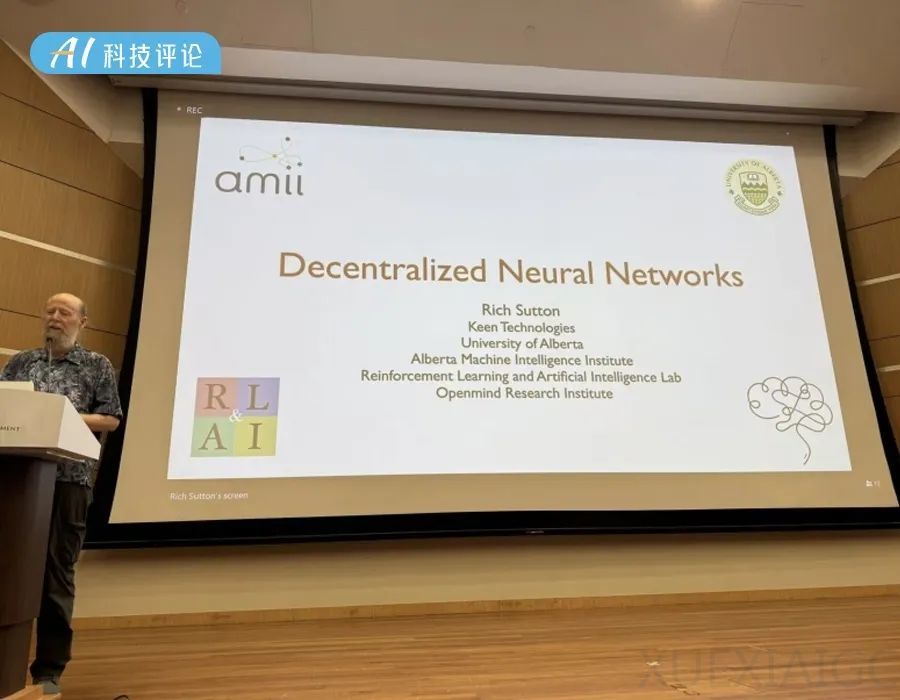

强化学习之父 Rich Sutton 最新演讲:用「去中心化神经网络」应对深度学习局限性

文章摘要

【关 键 词】 强化学习、深度学习、去中心化、持续学习、神经网络

在第六届国际分布式人工智能会议上,现代强化学习奠基人Richard S. Sutton教授提出了深度学习面临的挑战,包括灾难性遗忘、可塑性丧失和模型坍塌等现象,这些问题限制了人工智能的持续学习能力。Sutton教授提出了“去中心化神经网络”概念,主张每个神经元应有独立目标,如传递有效信息、保持活跃等,以实现网络的动态平衡和增强适应性。他介绍了持续反向传播算法,该算法通过选择性重新初始化部分神经元提升模型灵活性和学习效果,并在多个持续学习任务中表现优于传统方法。

Sutton教授强调,人工智能的发展不仅是技术进步,更是对智能的深刻理解,目标是创造出超越人类的智能生物,这将丰富经济、改变社会制度。他提出,理解自我、构建工具是人工智能领域的宏伟探索,需要以谦逊态度面对。他讨论了神经元作为有目标的Agent,强调去中心化神经网络的重要性,其中神经元追求的目标与整个网络的目标不同,没有中央控制器,而是多个Agent执行任务,形成一个强大的智能网络。

Sutton教授还提到,为了实现深度学习和人工神经网络的全部潜力,需要在未充分利用的人工神经元中增加额外的变化源,并保护和保留那些被认为有用的、变化的神经元。他展示了深度学习在持续监督学习中失去可塑性的证据,并提出了解决这些问题的新算法,如L2正则化、Shrink和Perturb,这些算法通过引入变异和选择性生存来解决深度学习的问题。他还讨论了持续反向传播算法,该算法通过选择性地重新初始化神经元来提升模型的灵活性和学习效果。

最后,Sutton教授提到了阿尔伯塔大学的新工作,关于流算法的研究,这些算法在各种标准深度强化学习任务上表现出色,提供了流式深度强化学习的新方法。他认为这些成果支持去中心化神经网络的观点,即基于去中心化的算法和神经元目标是让其他神经元听它们的。尽管这一联系尚待进一步验证,但Sutton教授认为这是一个值得探索的方向。

原文和模型

【原文链接】 阅读原文 [ 8477字 | 34分钟 ]

【原文作者】 AI科技评论

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★★☆