庞若鸣还有苹果论文?改善预训练高质量数据枯竭困境

文章摘要

【关 键 词】 SBP方法、大模型训练、数据利用、模型性能、数据效率

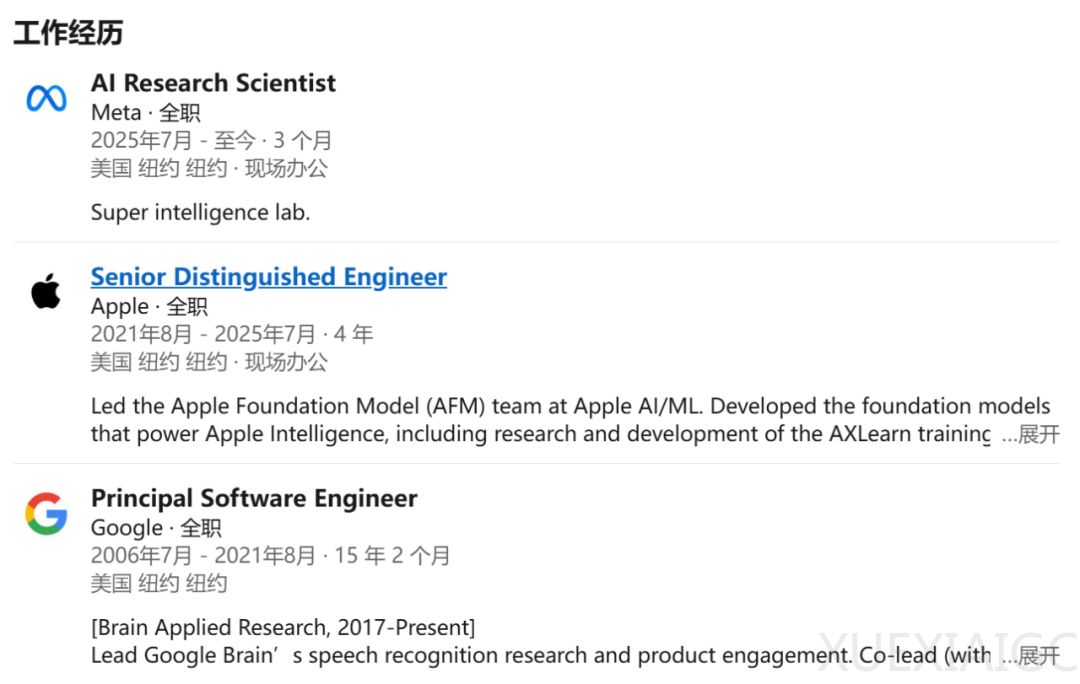

数月前,苹果基础模型团队负责人庞若鸣离职加入 Meta,但他在苹果参与的工作仍不断有高价值研究发表。此次介绍的论文 “Synthetic bootstrapped pretraining” 聚焦于大模型训练中的数据利用问题。

大规模语言模型以海量互联网文本训练,然而当前已触及真实数据规模瓶颈,高质量文本数据枯竭,亟需重新思考高效利用现有数据的方法。预训练的成功通常依赖文档内部 token 间的因果关联,但研究发现还存在跨文档的较弱相关性,来自预训练文档的潜在联合分布。基于此,研究团队提出假设,认为这种被标准预训练忽视的额外信号可通过合成数据捕捉,进而提升模型性能。

为利用这一潜在机会,研究者提出 Synthetic Bootstrapped Pretraining (SBP) 新预训练流程,分三步:一是相似文档对识别,在预训练数据集中找出语义相似文档对;二是条件建模,对文档对的条件概率建模构建 “数据合成器”;三是数据扩展,将合成器应用于预训练语料库生成新文本语料,编码跨文档相关性。

SBP 旨在解决大规模语言模型面临的 “规模壁垒”,将文档间相关性转化为训练信号。其具体实施步骤包括:最近邻配对,用外部模型编码文档并搜索相似对,过滤冗余;合成器调优,训练条件语言模型学习文档关系模式;大规模数据合成,应用合成器生成新语料,过滤低质量文档后与原始数据集联合训练。

从理论基础看,作者从贝叶斯视角解释 SBP 有效性,认为其使语言模型以多样化形式接触相同知识,增强泛化和表达能力。实验使用基于 Llama 3 架构的 3B 参数模型,在 DCLM 数据集上验证 SBP。结果显示,SBP 在多个规模和评估指标上优于基线方法,能从固定数据集中提取额外信号,且合成数据质量高,提供新信息而非简单重复。

SBP 具有多方面优势,包括提高数据效率、可自我改进、有理论基础且与模型规模扩展改进互补。这项工作为数据高效训练开辟新方向,随着领域接近数据限制,SBP 等方法对语言模型能力持续进步至关重要。

原文和模型

【原文链接】 阅读原文 [ 2826字 | 12分钟 ]

【原文作者】 机器之心

【摘要模型】 doubao-1-5-pro-32k-250115

【摘要评分】 ★★★★★