文章摘要

【关 键 词】 量化技术、模型优化、存储效率、推理速度、性能保持

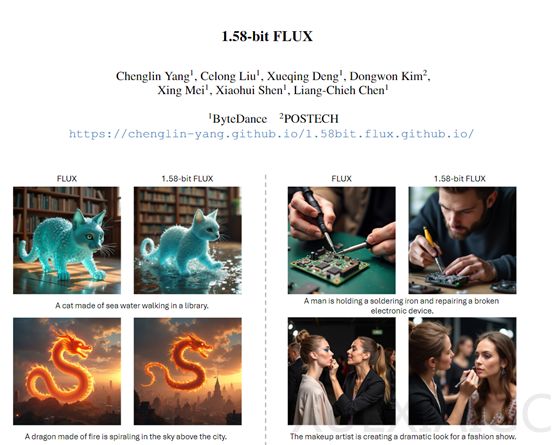

字节跳动研究人员针对大型语言模型(LLM)在推理和生成过程中占用大量内存的问题,提出了一种创新的量化方法。该方法不依赖实际图像数据,仅利用模型自身的自监督信号,成功将开源文生图像模型FLUX量化至1.58位权重,使用-1, 0, +1三种值表示,而非传统的浮点数。量化后的模型在生成1024 x 1024分辨率图像时,性能与未量化模型相当。为支持1.58位运算,研究团队开发了专用计算内核,存储需求减少7.7倍,推理内存减少5.1倍。

量化技术通过减少模型权重精度降低模型大小和计算需求。传统深度学习模型中,权重以32位浮点数存储,占用大量内存。量化技术将权重映射到更少的位表示,如8位或更低,显著减少存储需求,并减少推理时的计算量。在1.58位FLUX研究中,量化技术将权重量化至1.58位,仅用三个数值表示。

为保持低精度下的模型性能,研究团队采用后训练量化(PTQ)方法,直接对预训练模型进行量化处理,避免重新训练带来的计算开销和时间消耗。此外,研究团队还开发了针对1.58位操作优化的自定义内核,优化数据存储结构和访问模式,降低内存占用,提高计算效率。

在不同GPU上测试,1.58位FLUX借助自定义内核实现推理内存使用量大幅减少,超过5.1倍。自定义内核通过优化计算流程,减少不必要的计算步骤和数据传输,提高模型推理速度,降低推理延迟。在GenEval数据集和T2I CompBench验证分割上评估,1.58位FLUX在多个指标上与FLUX相当,证明量化后模型在保持性能方面的优势。

1.58位FLUX在模型存储和推理内存方面显示出显著效率提升,检查点存储减少7.7倍。在推理延迟方面,1.58位FLUX在不同GPU上的表现也有所提升,尤其是在性能较低但适合部署的GPU上,如L20和A10,推理延迟得到显著改善。研究人员表示,该量化方法将很快开源,帮助更多受算力、内存限制的人员实现更高效的模型推理。

原文和模型

【原文链接】 阅读原文 [ 1390字 | 6分钟 ]

【原文作者】 AIGC开放社区

【摘要模型】 moonshot-v1-32k

【摘要评分】 ★★★☆☆