作者信息

【原文作者】 Hugging Face

【作者简介】 The AI community building the future.

【微 信 号】 Hugging-Face

文章摘要

【关 键 词】 Gemma、Hugging Face、开源、微调、LoRA

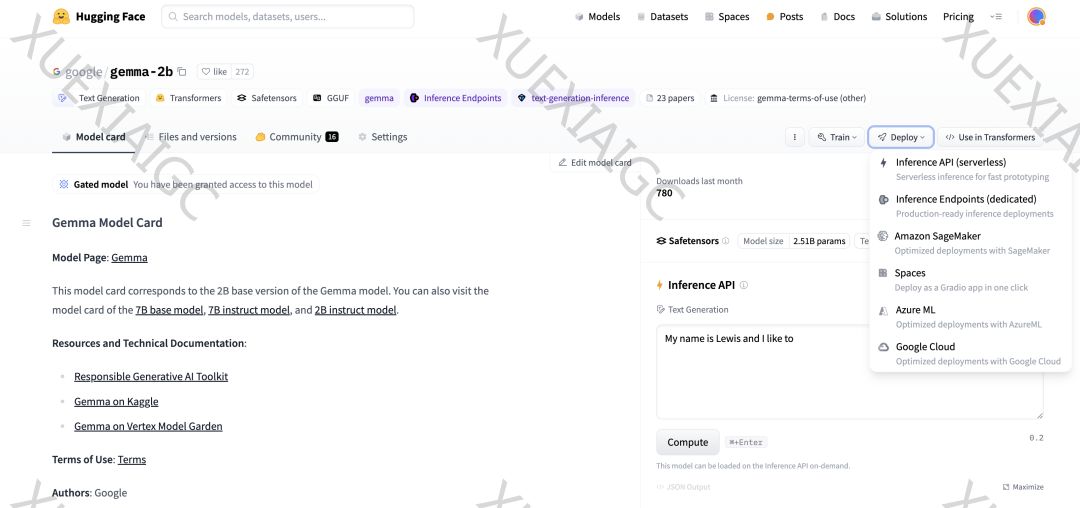

在这篇文章中,我们将介绍 Google Deepmind 开放的 Gemma 语言模型,它现在可以通过 Hugging Face 向更广泛的开源社区开放。Gemma 提供了两个规模的版本:2B 和 7B 参数,包括预训练版本和经过指令调优的版本。该模型在 Hugging Face 平台上提供支持,可以在 Vertex Model Garden 和 Google Kubernetes Engine 中轻松部署和微调。Gemma 模型非常适合利用 Colab 提供的免费 GPU 资源进行原型设计和实验。

文章重点介绍了如何使用 Hugging Face Transformers 和 PEFT 库在 GPU 和 Cloud TPU 上对 Gemma 模型进行参数高效微调(PEFT),这对于希望在特定数据集上微调 Gemma 模型的用户非常有用。PEFT 是一种低成本的方法,适用于内存和计算资源有限的用户。文章还介绍了低秩适应(LoRA)技术,这是一种参数高效微调技术,它只针对模型参数的一小部分进行微调。

在开始微调之前,用户需要填写同意表格以访问 Gemma 模型文件。微调过程中,我们使用了英文“名人名言”数据集,并使用 LoRA 配置对模型进行了微调。最终,我们得到了符合预期格式的答案。

此外,文章还提到了在 TPU 环境下微调 Gemma 模型,可以通过 SPMD 上的 FSDP 加速。最后,文章鼓励用户浏览 Gemma 文档和发布博客,以获取更多关于训练、微调和部署 Gemma 模型的信息。

摘要: Google Deepmind 的 Gemma 语言模型现已通过 Hugging Face 对开源社区开放,提供了两个版本的模型参数。文章介绍了如何使用 PEFT 库在 GPU 和 Cloud TPU 上进行参数高效微调,特别是利用 LoRA 技术。通过微调,Gemma 模型能够生成符合特定格式的名言金句。文章还提到了在 TPU 环境下使用 FSDP 加速微调的方法,并鼓励用户探索更多关于 Gemma 模型的信息。

原文信息

【原文链接】 阅读原文

【原文字数】 1550

【阅读时长】 6分钟